В прошлой записке я установил гипервизор ESXi 6 на голое железо. Показал как создавать виртуальную машину. В этой записке пойдет речь уже о VCSA (vCenter), все преимущества виртуализации от компании VMware вы можете увидеть установив центр управления VCSA (vCenter). Компания VMware, называет связку из серверов с установленными гипервизорами ESXi и одним центром управления VCSA, одним общим именем "VMware vSphere".

Под преимуществом по сравнению с одиночным гипервизором я понимаю:

- Функции отказоустойчивости

- Балансировка нагрузки

- Легкое резервное копирование через Veeam Backup

- Простое управление кластером (группой хостов с гипервизорами)

- и куча других возможностей

Использовать только один хост с гипервизором ESXi - как-то не красиво, бедно :). При таком использовании много минусов, да и конкурент в лице KVM дышит в спину, причем предлагая те же возможности и даже больше, только изначально все за бесплатно.

VMware vSphere - это платформа виртуализации позволяющая запускать виртуальные машины (ВМ) и обеспечивающая множество функции по отказоустойчивости, управляемости и масштабируемости, пригодная как для маленьких компаний, так и для больших датацентров.

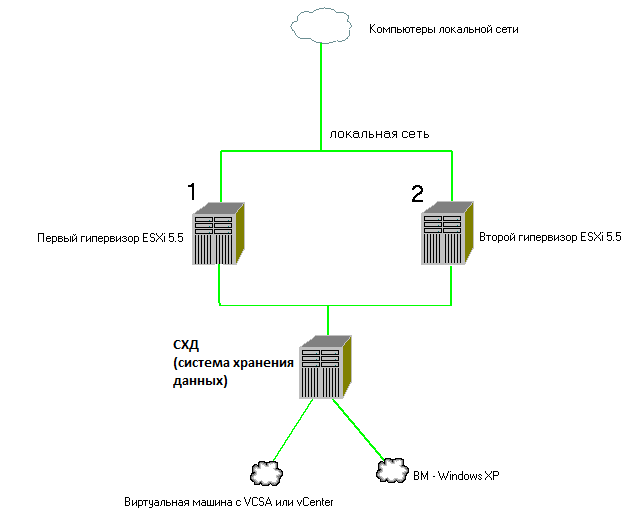

Как я уже писал, vSphere - это группа серверов на которых установлен гипервизор ESXi и всего один сервер под управлением vCenter Server. Сервер vCenter нужен только один и он может работать внутри виртуальной машины того же ESXi (на одном из группы), которым управляет. У вас может быть много серверов ESXi с одним центром управления.

По сути VMware vSphere состоит из следующих компонентов:

1. ESXi хосты - это серверы с установленной операционной системой ESXi Server. Этот ESXi Server и есть гипервизор.

2. vCenter Server - это сервер управления, который имеет графическую консоль. vCenter объединяет весь функционал vSphere, из под него можно настроить возможности по отказоустойчивости, безопасности, управляемости и перемещению ВМ (виртуальных машин).

vCenter Server есть в двух вариантах:

1. vCenter for Windows

2. vCenter Server Appliance (VCSA)

Первый вариант устанавливается на ОС Windows и использует СУБД MS SQL Express, обычно поставляется как установочный дистрибутив. Второй вариант - это готовая Linux операционная система OpenSUSE с инсталированным vCenter и Postgresql. Идет в виде файла шаблона с расширением .OVA. Этот шаблон похож на ISO образ с готовым Linux + VCSA. В общем, OVA файл - это как бы ISO образ который используют для переноса или распространения виртуальных машин. Допустим вы захотели перенести одну ВМ на другой сервер, заходите на гипервизор, берете и экспортируете ВМ в образ OVA. И далее импортируете этот файл уже на другом гипервизоре или распространяете его по интернету.

OVA (OVF)- это открытый стандарт для хранения и распространения виртуальных машин. Стандарт описывает открытый, переносимый, расширяемый формат для распространения образов виртуальных машин. Стандарт OVA (OVF) не привязан к какой-либо реализации гипервизора или аппаратной архитектуре.

КРАТКОЕ СОДЕРЖАНИЕ

1. Немного про тестовый стенд

2. Что будет установлено

3. Конфигурация ПК

4. Настройка серверов

4.1. Общее хранилище данных №1

4.2. Хост с гипервизором ESXi №1 и №2

5. Устанавливаем гостевые виртуальные машины

5.1. Малюсенькая Windows XP SP3

5.2. Система управления vCSA

6. Тестируем фичи виртуализации

6.1. High Availability

6.2. DRS

6.3. Fault Tolerance

7. Резервное копирование через Veeam

8. Конвертация машин

1. Немного про тестовый стенд

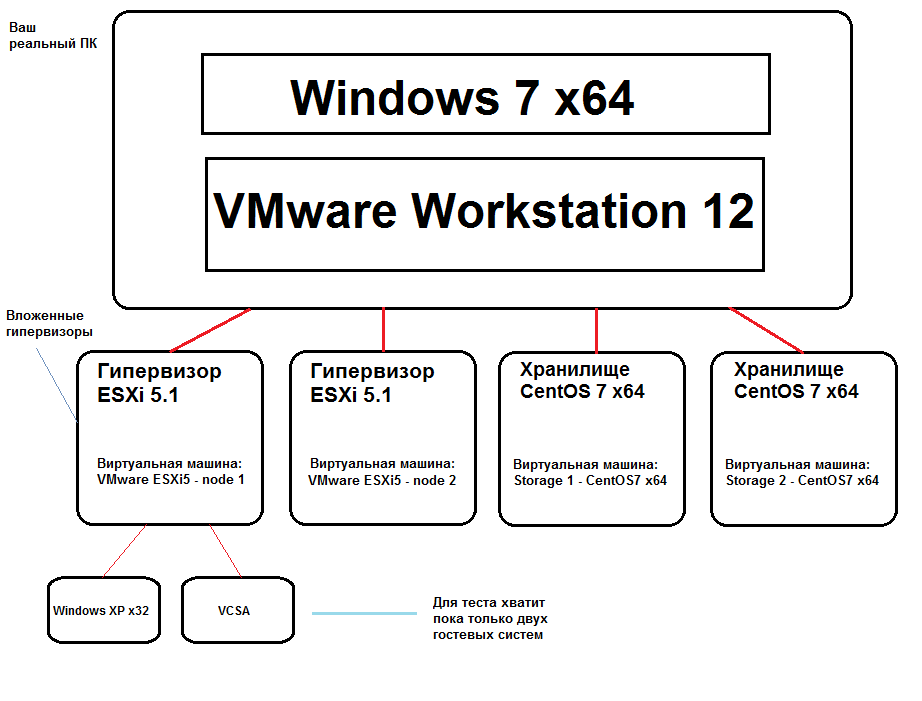

Чтобы посмотреть как работает популярный продукт виртуализации от VMware, не обязательно иметь для этого физические сервера. При наличии средненького ПК, вы можете запустить все гипервизоры VMware у себя в десктопном VirtualBox или VMware Workstation. Такой запуск гипервизора в гипервизоре называют Nested Virtualiztation. То есть - вложенная виртуализация.

Вот как это выглядит в Workstation:

2. Что будет установлено

В этом разделе оглашен списков программ которые будут установлены и настроены:

- Гипервизоры ESXi 5.1 в кол-ве двух штук

- Система управления VMware vCenter Server Appliance (VCSA) как гостевая система внутри ESXi 5.1

- Windows XP SP3 как гостевая система внутри ESXi 5.1

- iSCSI таргет LIO, NFS сервер и DNS служба на CentOS 7

3. Конфигурация ПК

Для запуска тестовой виртуальной среды, понадобится мощный компьютер, поэтому потребуется следующее:

1. Компьютер с минимальной конфигурацией:

- CPU 4-ядра и больше с поддержкой аппаратной виртуализации amd-v или Intel vt-x. Старые intel процессоры Q8300 и 9200 имеют не полную поддержку виртуализации, у них нет EPT, которая позволяет запускать вложенные гипервизоры. Идеально было бы, если процессор имел 8 ядер.

- Оперативная память минимум 8Гб, а лучше 12, 16 или 32Гб

- Жесткий диск 500Гб, плюс желательно SSD для размещения виртуальных машин или некоторых дисков. Твердотельный диск хорошо ускоряет работу вложенных виртуальных машин. Можно обойтись без него, создав программный рейд из двух HDD уровня 0. Если нету ни того и не другого, придется жертвовать временем - установка и другие операции будут совсем очень медленными. И это будет бесить, у нас же не железные яйца.

2. На компьютере с 8 (16/32) Гб иметь установленную Windows 7 x64 или другую аналогичную ОС. Запускать гипервизоры esxi лучше всего в VMware Workstation версии 12. В VirtualBox можно тоже запустить, правда скорость работы субъективно меньше - есть мелкие притормаживания и неудобства при создании гостевых ВМ внутри esxi, придется прописывать дополнительные параметры в конфигурационном файле .vmx созданной ВМ - vhv.enable = "TRUE", что не удобно. Есть еще глюк в VBOX, гость WinXP созданный в esxi не показывает графику.

3. Для создания тестового стенда в VMware workstation, нужно установить как минимум 3 виртуальных машины - гостевых систем:

- esxi1 – гипервизор первый

- esxi2 – гипервизор второй

- iscsi/nfs/dns - хранилище данных первое

И можно добавить 4-й сервер как резервное хранилище:

- iscsi/nfs - хранилище данных второе

В итоге получилось 4 гостя, а в реальности 4-ре физических сервера. В принципе роль dns можно отделить и запустить на отдельной гостевой машине вложенного гипервизора esxi. Это повысить отказоустойчивость и упростит бекап.

4. Настройка серверов

Устанавливаем CentOS 7 на VMware Workstation. Далее идет настройка.

Настройка DNS сервера - здесь настроим имена хостов, доменную часть берем свою, я взял asia.local.

Устанавливаем Bind:

# yum install bind –y

Редактируем файл /etc/named.conf

# vi /etc/named.conf

// // named.conf // // Provided by Red Hat bind package to configure the ISC BIND named(8) DNS // server as a caching only nameserver (as a localhost DNS resolver only). // // See /usr/share/doc/bind*/sample/ for example named configuration files. // options { listen-on port 53 { 10.0.10.20; 127.0.0.1; }; listen-on-v6 port 53 { ::1; }; directory "/var/named"; dump-file "/var/named/data/cache_dump.db"; statistics-file "/var/named/data/named_stats.txt"; memstatistics-file "/var/named/data/named_mem_stats.txt"; allow-query { localhost; any; }; /* - If you are building an AUTHORITATIVE DNS server, do NOT enable recursion. - If you are building a RECURSIVE (caching) DNS server, you need to enable recursion. - If your recursive DNS server has a public IP address, you MUST enable access control to limit queries to your legitimate users. Failing to do so will cause your server to become part of large scale DNS amplification attacks. Implementing BCP38 within your network would greatly reduce such attack surface */ recursion yes; dnssec-enable no; dnssec-validation no; /* Path to ISC DLV key */ bindkeys-file "/etc/named.iscdlv.key"; managed-keys-directory "/var/named/dynamic"; pid-file "/run/named/named.pid"; session-keyfile "/run/named/session.key"; }; zone "asia.local" { type master; file "asia.local.fwd"; allow-update {none;}; allow-transfer {none;}; }; zone "10.0.10.in-addr.arpa" { type master; file "asia.local.rev"; allow-update {none;}; }; logging { channel default_debug { file "data/named.run"; severity dynamic; }; }; zone "." IN { type hint; file "named.ca"; }; include "/etc/named.rfc1912.zones"; include "/etc/named.root.key";

Создаем файл прямой и обратной зоны.

# vi /var/named/asia.local.fwd

$TTL 86400

@ IN SOA ns1.asi.local. root.asia.local. (

2014120801 ;Serial ВАЖНО !!! серийный номер должен меняться в большую строну при каждом изменении, иначе slave сервера не обновят данные

3600 ;Refresh

1800 ;Retry

604800 ;Expire

86400 ;Minimum TTL

)

; Указываем два name сервера

IN NS ns1.asia.local.

; Определяем IP адреса name серверов

ns1 IN A 10.0.10.20

; Define hostname -> IP нашего сервера для этого домена

vc IN A 10.0.10.30

esxi1 IN A 10.0.10.10

esxi2 IN A 10.0.10.11

dstore1 IN A 10.0.10.20

dstore2 IN A 10.0.10.21

Обратная зона:

# vi /var/named/asia.local.rev

$ORIGIN 10.0.10.in-addr.arpa.

$TTL 3D

@ SOA ns1.asia.local. admin.asia.local. (13 4h 1h 1w 1h)

@ IN NS ns1.asia.local.

30 IN PTR vc.asia.local.

10 IN PTR esxi1.asia.local.

11 IN PTR esxi2.asia.local.

20 IN PTR ns1.asia.local.

На этом настройка DNS сервера завершена.

НАСТРОЙКА ХРАНИЛИЩЕ ДАННЫХ iSCSI

Здесь отдадим на растерзание виртуальным машинам один жесткий диск.

Очищаем текущею конфигурацию

# targetcli clearconfig confirm=true

# targetcli

Отдаем жесткий диск LIO:

> cd /backstores/block

> create hdd_block1 /dev/sdb

Отключаем авторизацию:

/> cd /iscsi

/iscsi> set discovery_auth enable=0

Создаем WWN:

/iscsi> create

Создаем единственный LUN, наберите "cd iqn" и нажмите TAB:

/iscsi> cd iqn.2003-01.org.linux-iscsi.localhost.x8664:sn.5b94cfd9bd9a/

/iscsi> cd tpg1/luns

/iscsi> create /backstores/block/hdd_block1

Created LUN 0.

/iscsi> cd ..

Создаем ACL:

/iscsi> cd acls

/iscsi> create iqn.1991-05.com.microsoft:node01

Created Node ACL for iqn.1991-05.com.microsoft:node01

Created mapped LUN 0.

/iscsi> cd ..

Создаем portal:

/iscsi> cd portals

/iscsi> create

/iscsi> cd /

Сохраняем конфиг

/> saveconfig

НАСТРОЙКА ХРАНИЛИЩЕ ДАННЫХ NFS

Здесь отдадим два каталога для нужд виртуализации:

- /nfs/iso - для установочных ISO образов

- /nfs/guestimages - для некоторых виртуальных машин

Устанавливаем NFS:

# yum install nfs-utils -y

# systemctl enable rpcbind nfs-server

# systemctl start rpcbind nfs-server

Отдадим два каталога:

- /nfs/iso

- /nfs/guestimages

# mkdir -p /nfs/iso && mdkdir /nfs/guestimages

Первый каталог будет содержать установочные ISO образы.

Второй каталог для некоторых гостевых виртуальных машин.

# vi /etc/exports

/nfs/iso *(rw,no_root_squash)

/nfs/guestimages *(rw,no_root_squash)

# exportfs -r

Таким же способом ставим второй сервер СХД. При настройке задаем IP адрес 10.0.10.21 и имя хоста dstore2. Роль DNS поднимать не стоит.

ИТОГО:

- Настроено хранилище данных iSCSI и NFS

- Настроен DNS сервер

4.2. Хост с гипервизором ESXi №1 и №2

Это уже другой физический сервер, в нашем случае вложенный гипервизор esxi внутри Workstation. Создадим гостевую машину и установим гипервизор ESXi 5.1, аналогичным образом потребуется установить другой гипервизор этой же версии. Два гипервизора позволят добиться отказоустойчивости в случае падения одного из них.

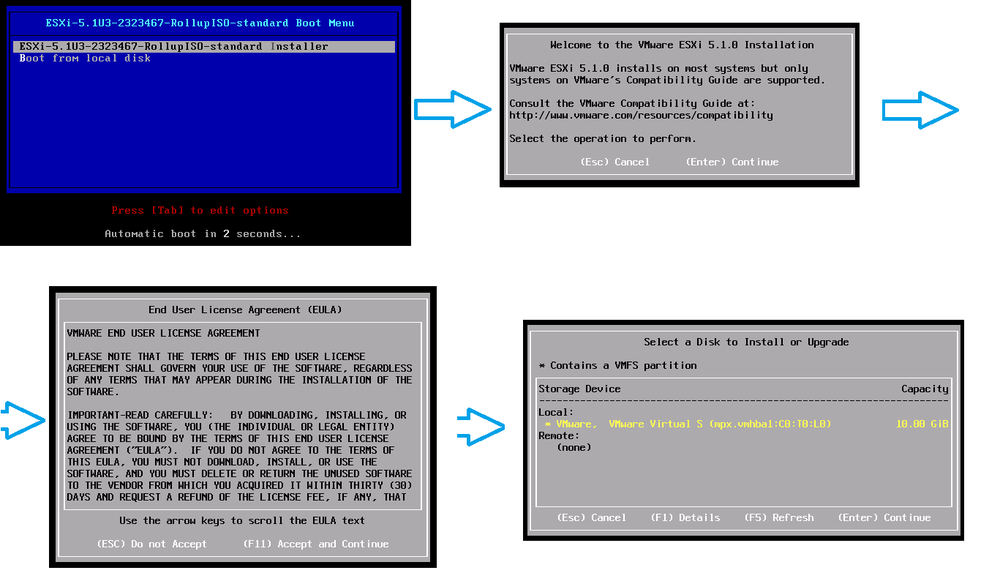

УСТАНОВКА ESXi v5.1 - ГИПЕРВИЗОР 1

Создание ВМ в Workstation делается просто, если есть вопросы Гугл в помощь. При создании укажите ISO образ VMware-VMvisor-Installer-5.1.0.update01-3029758.x86_64.iso. Далее запустите ее и смотрим:

Теперь когда гипервизор установлен, его надо до настроить:

1. Задать его сетевой карте статический IP адрес

2. Задать имя хоста и DNS сервер

3. Задать суффикс (домен)

Задаем статический IP адрес

Нажимаем F2 чтобы войти в настройки, запросят пароль root. Далее идем в Configure Managment Network -> IP Configuration ->

Задаем IP адрес, маску и деволтный шлюз.

Задаем имя хоста

Идем в Configure Managment Network -> IP Configuration -> DNS Configuration

Задаем имя хоста и DNS сервер

Задаем доменный суффикс

Идем в Configure Managment Network -> IP Configuration -> Custom DNS Suffixes

Задаем доменную часть.

ИТОГО:

- Установлен гипервизор ESXi v5.1

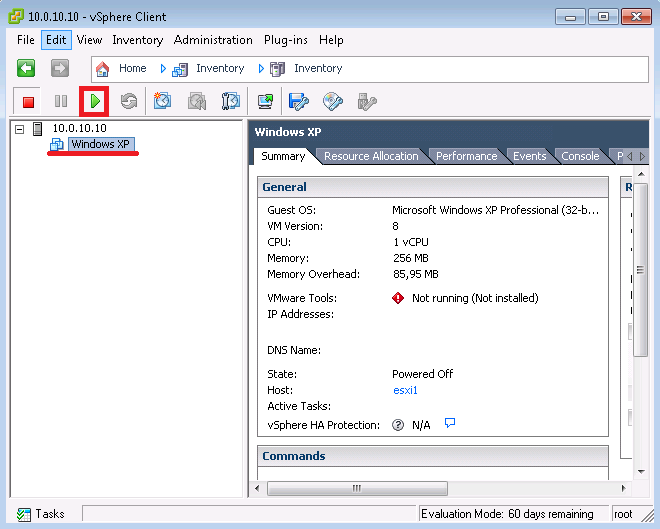

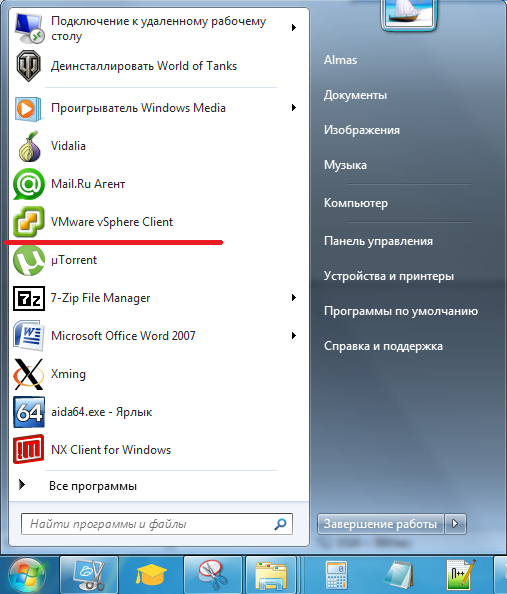

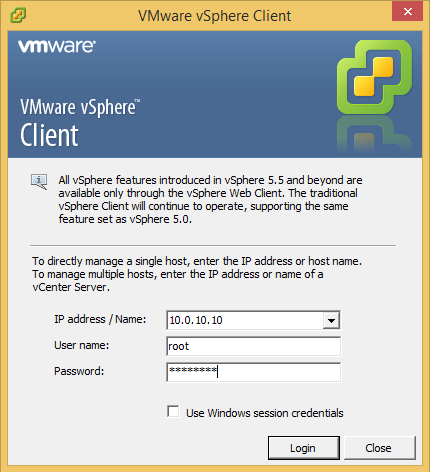

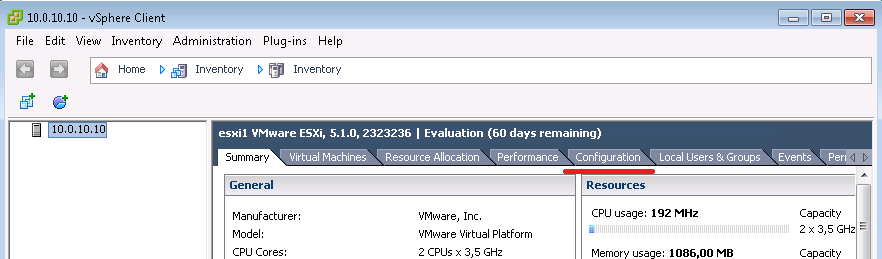

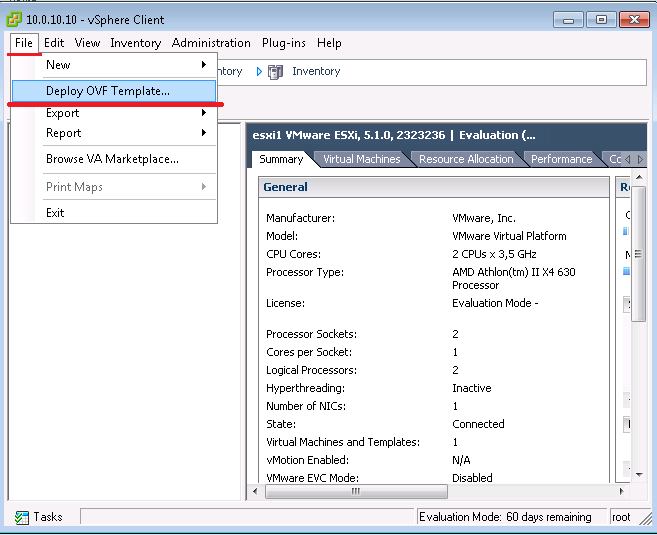

ВХОД ЧЕРЕЗ КЛИЕНТ vSphere Client на только что установленный гипервизор ESXi

Запускаем браузер и идем на страничку https://10.0.10.10

Качаем vSphere Client через указанную ссылку.

Вся работа с гипервизором ESXi или с центром управления vCenter идет именно через этот толстый клиент. Он устанавливается на операционную систему Windows. Также есть возможность управления в виде тонкого клиента - веб интерфейс.

Через этот толстый клиент создаются гостевые системы, а также если вы подключились к vCenter или VMware vCenter Server Appliance (vCSA), вам будут доступны функции по созданию кластера.

Устанавливаем закаченный файл.

После чего, в меню Пуск появится значок VMware vSPhere Client.

Запустите его щелкнув по пиктограмме "VMware vSphere Client"

Вводим IP адрес первого гипервизора, так как у нас работает DNS сервер, за место IP понятней будет вводит имя хоста - esxi1.asia.local

Введите логин/пароль - root / Ваш пароль

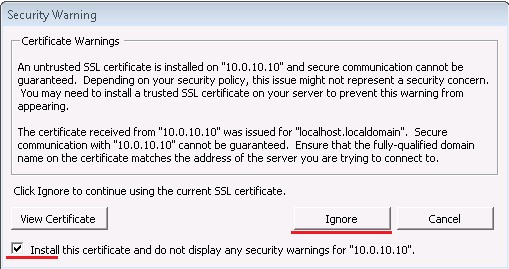

Здесь нажимаем "Ignore" и ставим галку, так как соединение с гипервизорм идет через самоподписанный сертификат, который сделан автоматически во время установки. Чтобы сообщение не появлялось, мы поставили галку, чтобы сертификаты импортировались на свой ПК.

Нажимаем ОК

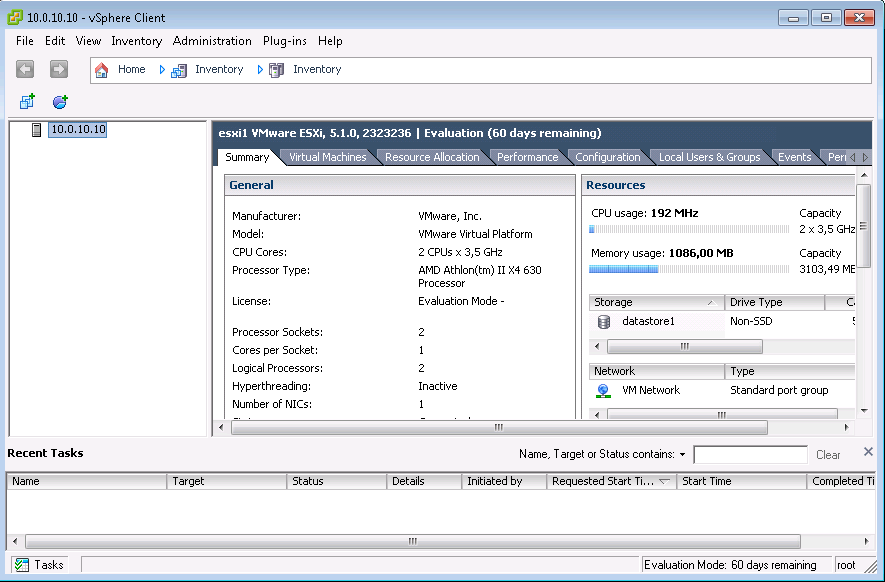

И попадаем в главное окно гипервизора ESXi.

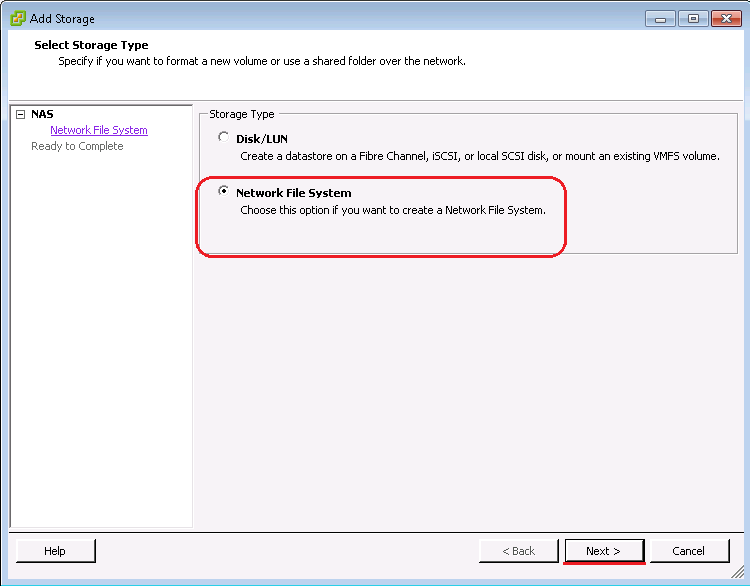

ПОДКЛЮЧАЕМ НАШЕ ХРАНИЛИЩЕ - DATASTORES

До этого мы создали простое NFS и iSCSI хранилище. Теперь нам осталось их подключить в гипервизоре ESXi.

В ESXi хранилище обзывают как Datastore. Чтобы добавить iSCSI хранилище, потребуется указать интерфейс по которому будет ходить iSCSI трафик. У нас всего один сетевой адаптер на машине с гипервизором ESXi, поэтому выбора как такого нет. По идее в реальной сети трафик с СХД к гипервизору и обратно, должен идти по отдельному сетевому адаптеру, а трафик клиентской части по другой сетевой карте. Смешивать пользовательский и серверный трафик плохая идея. Но для теста можно использовать одну карту.

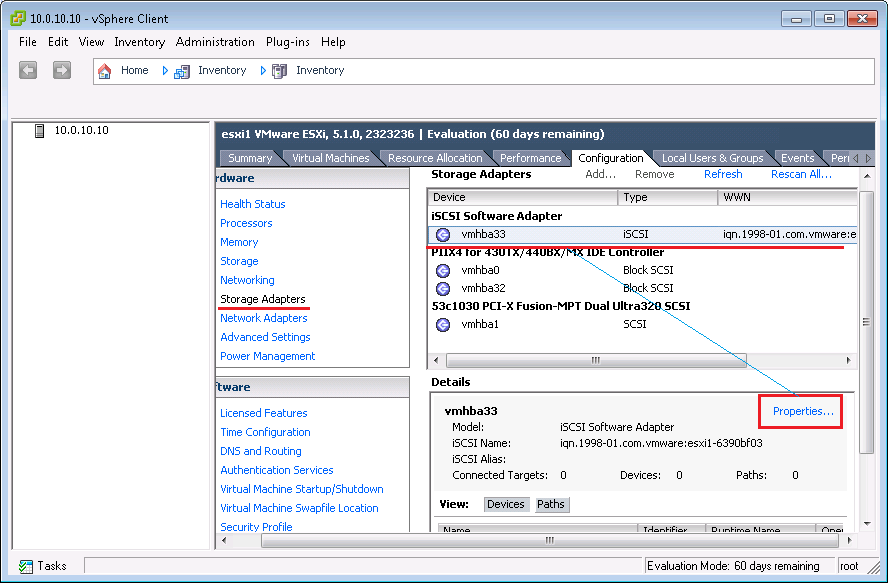

Идем в вкладку Configuration

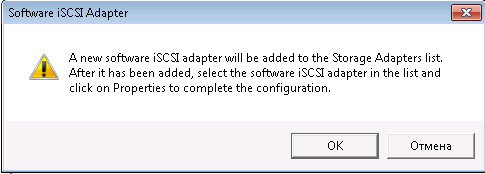

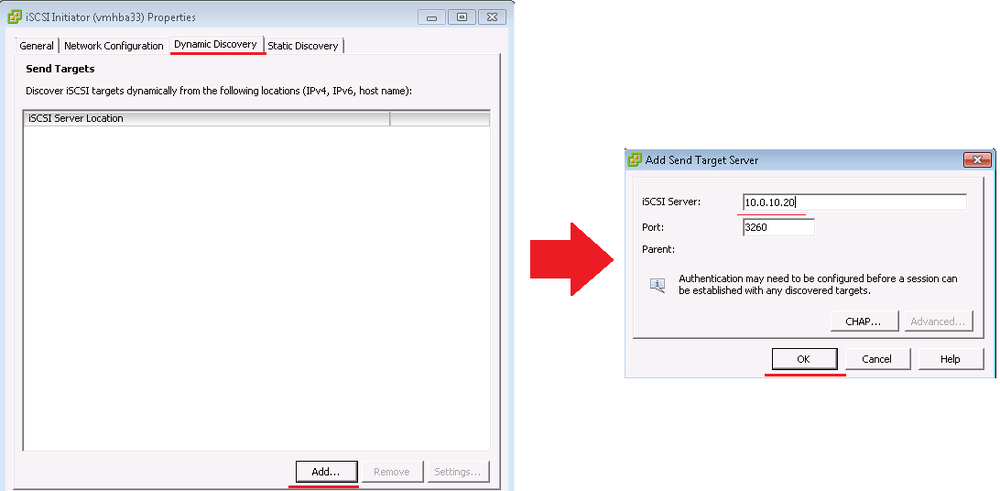

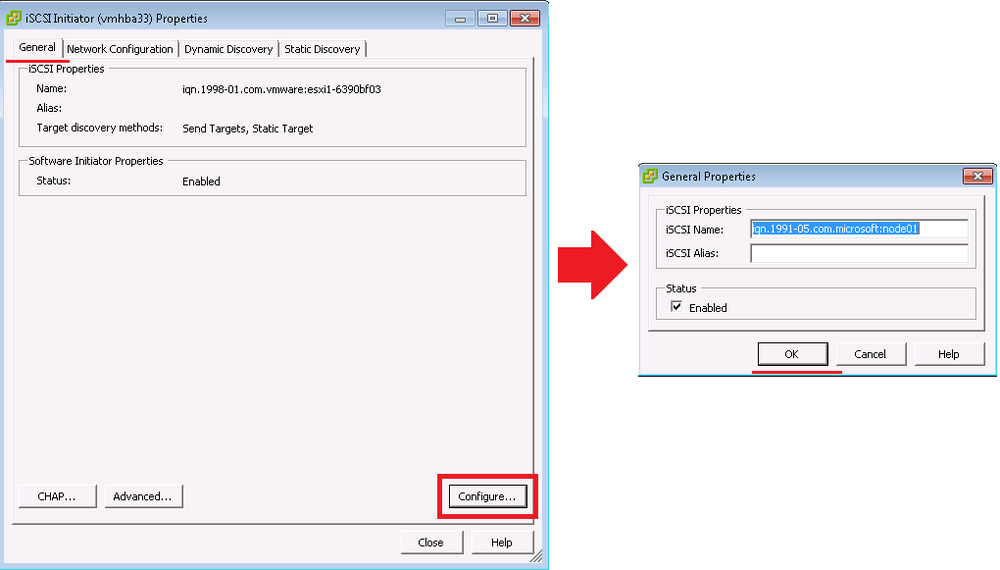

Далее добавляет программный адаптер iSCSI - Storage Adapters ➜ Add ➜ Add Software iSCSI Adapter

Нажимаем ОК

Нажимаем ОК. Теперь можно добавить доступ к СХД по протоколу iSCSI.

Выделяем только что созданный программный iSCSI адаптер и нажимаем Properties

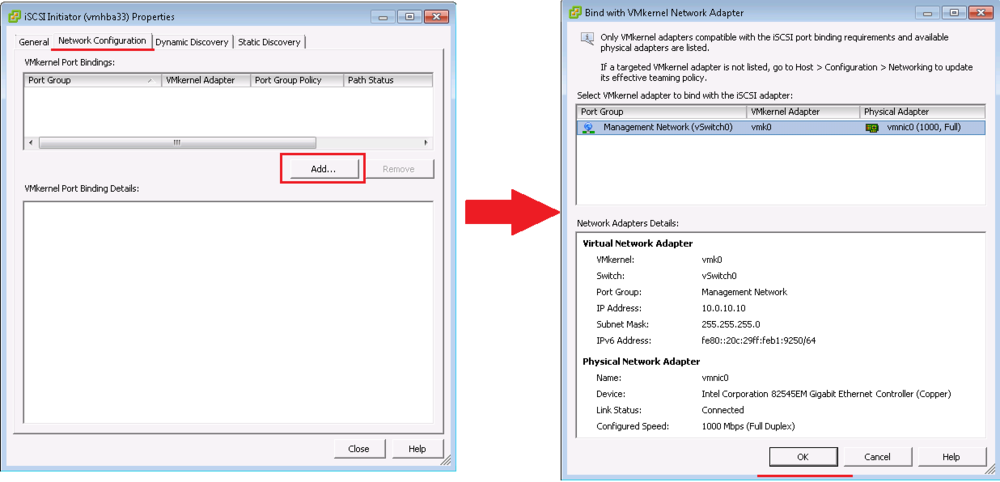

Идем во вкладку Network Configuration ➜ Add ➜ OK

Тем самым указывая гипервизору, что iSCSI трафик будет идти через наш единственный интерфейс.

Добавляем IP адрес сервера СХД.

Прописываем строчку авторизации - iqn.1991-05.com.microsoft:node01

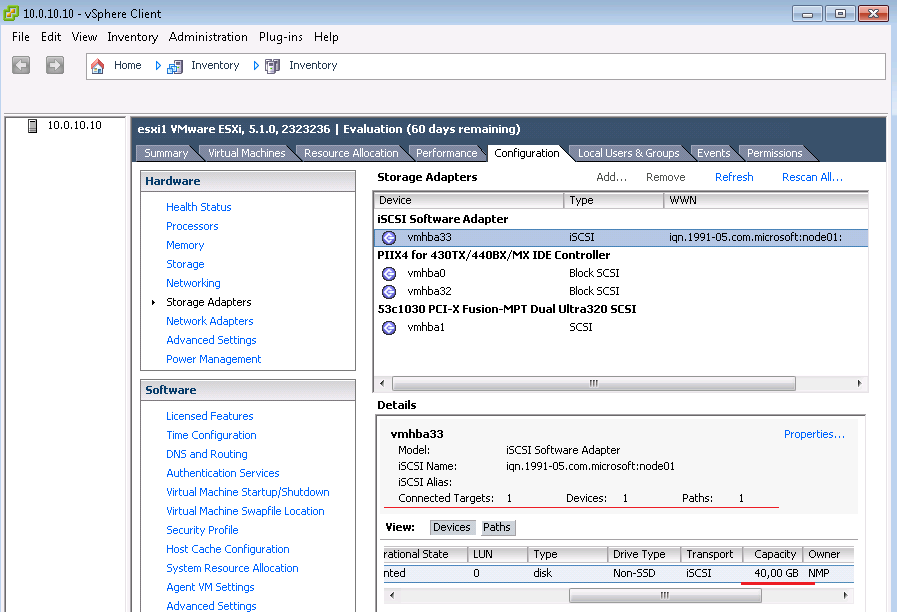

Здесь видно, что есть подключение к одному Таргету и его объем 40Гб. Но этого мало..., если Таргет не появился, придется добавить его в ручную.

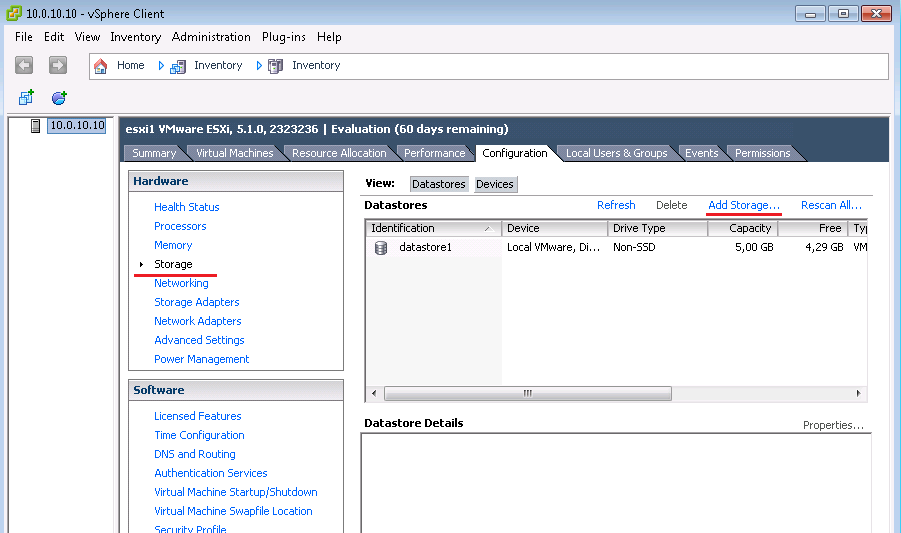

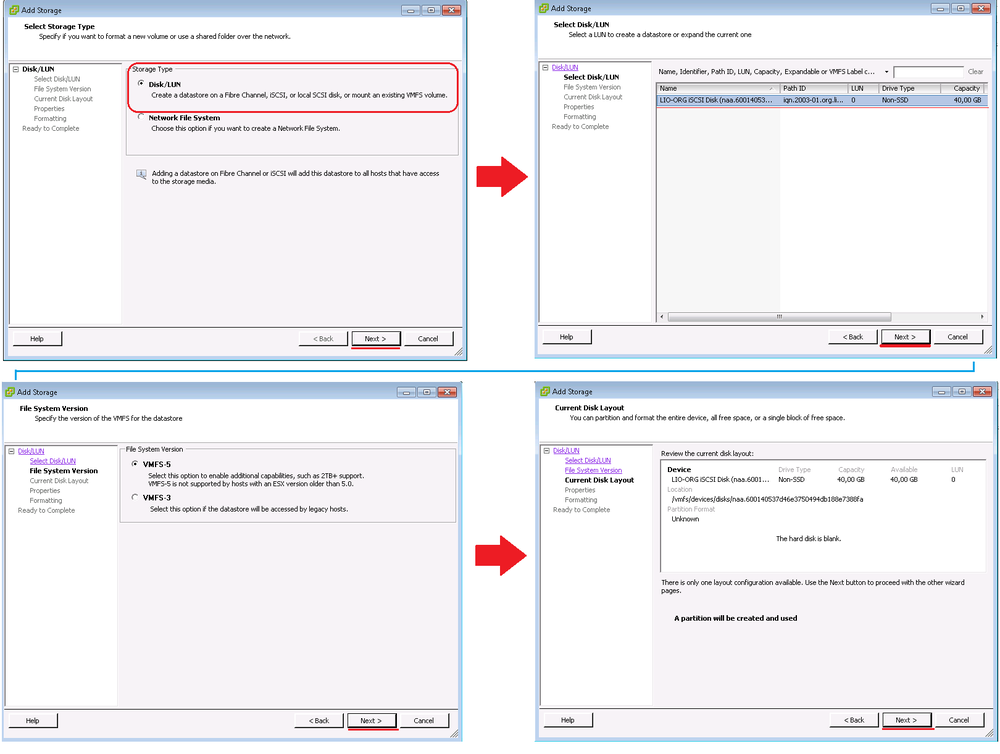

Идем в Storage ➜ Add Storage

Доступ по iSCSI до СХД настроен.

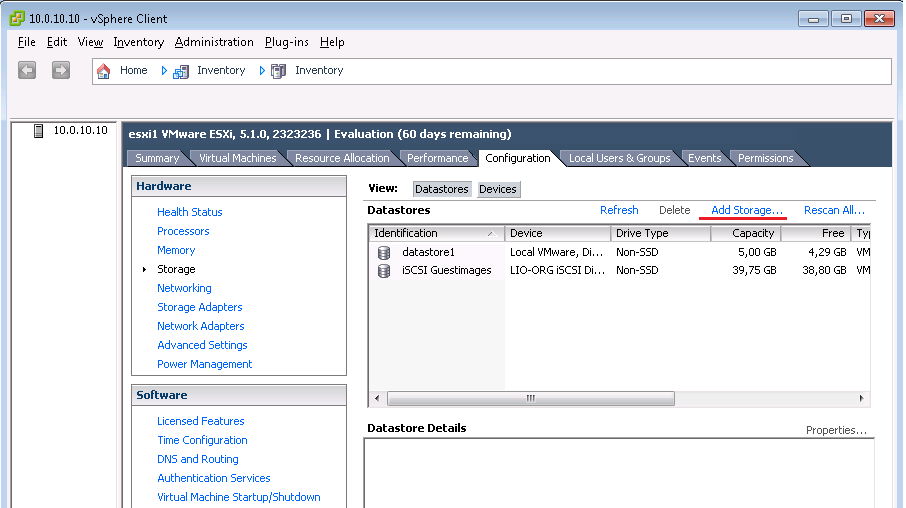

Теперь нужно добавить NFS Датастор.

Нажимаем Add Storage...

Выбираем Network File System (NFS)

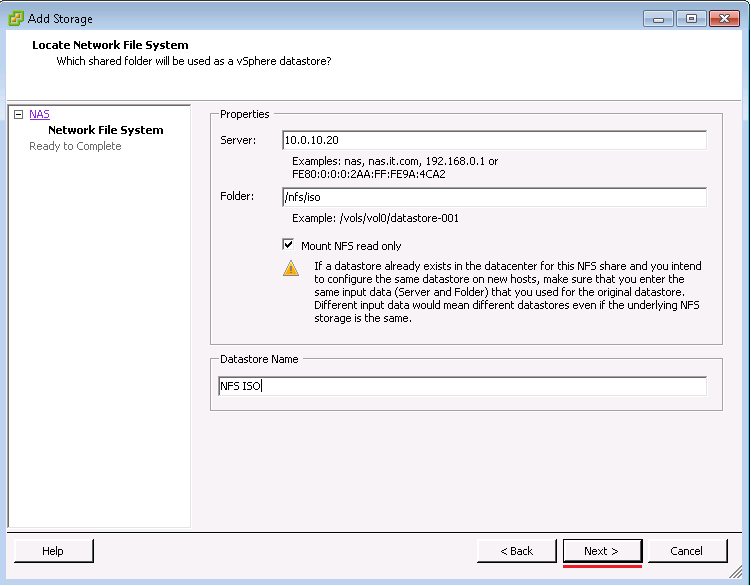

Здесь прописываем IP адрес сервера NFS и его каталог /nfs/iso, даем имя датастору NFS ISO

В нем будут установочные образы операционных систем и разных программ.

Аналогичный образом добавляем NFS датастор для образов ВМ, только теперь указываем каталог: /nfs/guestimages:

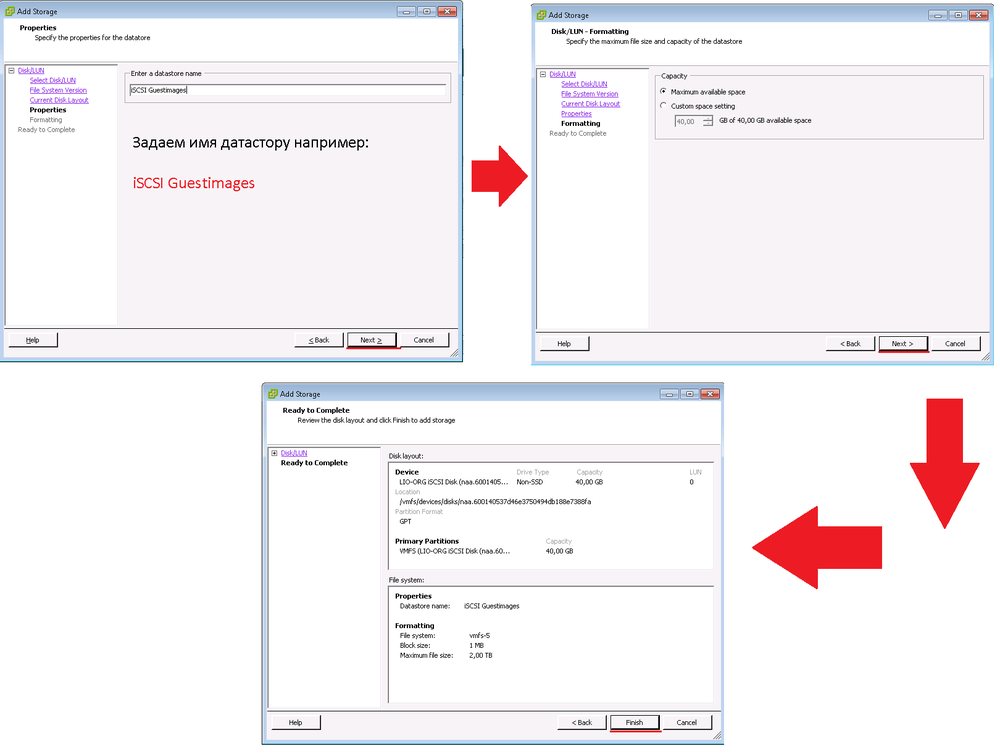

ИТОГО:

- В гипервизоре ESXI настроен доступ к СХД по NFS и iSCSI протоколам

Аналогичным образом установите второй сервер с ESXi, дайте ему имя хоста - esxi2.asia.local и IP адрес 10.0.10.11. Задайте DNS сервер 10.0.10.20 и настройте доступ к СХД NFS и iSCSI.

5. Устанавливаем гостевые виртуальные машины

Здесь установим две гостевые системы Windows XP и VCSA (OpenSuse).

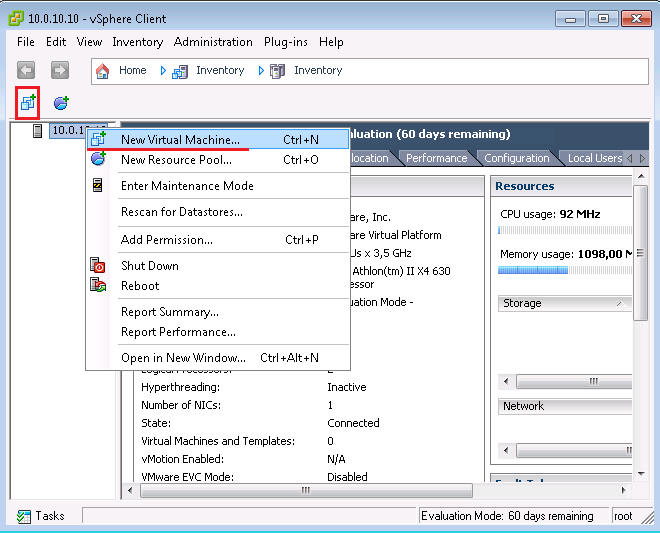

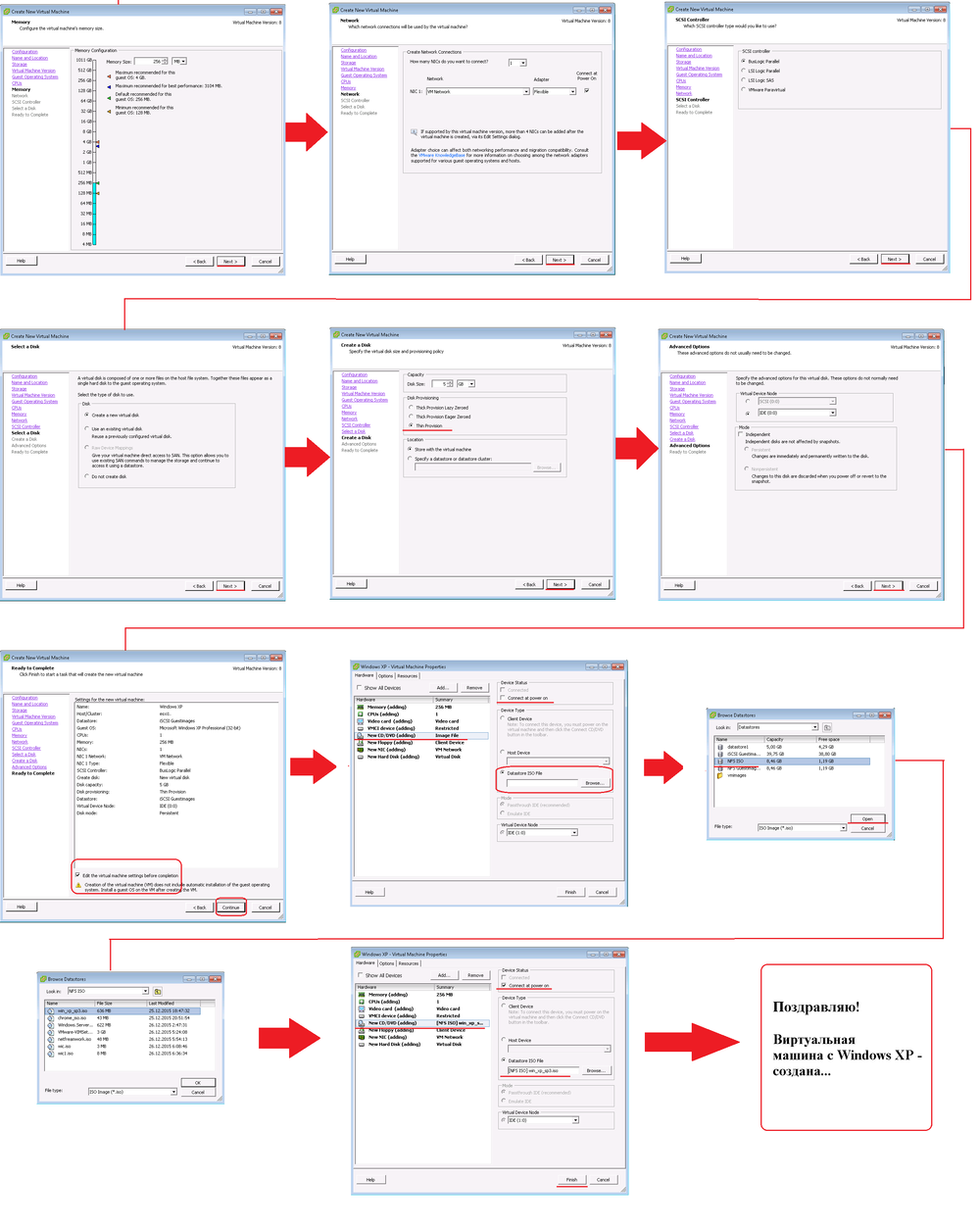

Создаем первую гостевую виртуальную машину Windows XP SP3:

И далее маленькие скрины:

Теперь запускаем ее.

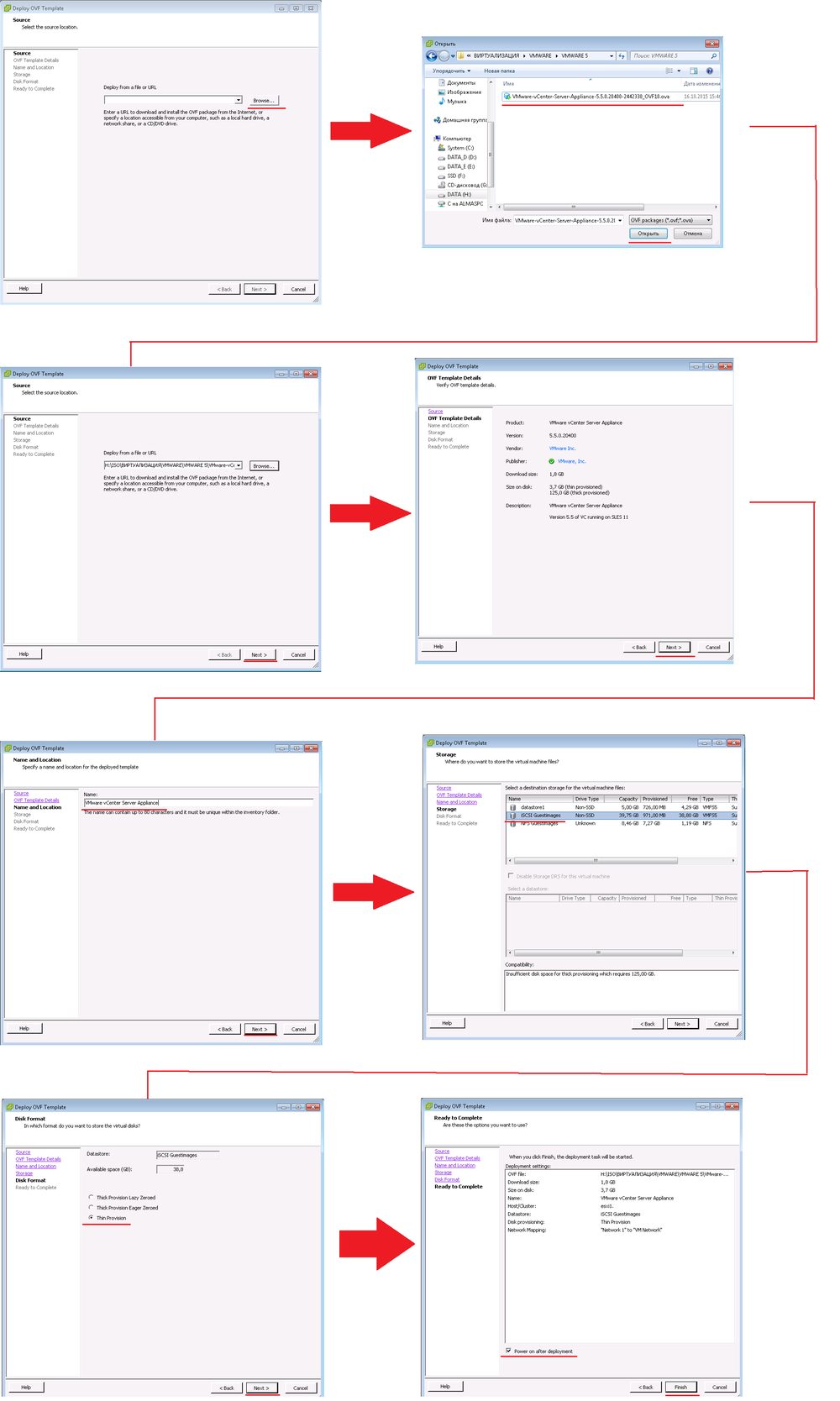

5.2. Система управления vCSA

Установим VCSA, для этого нам понадобится образ с расширением .ova

Виртуальная машина в формате .ova - это готовая ВМ внутри которой есть главные файлы .vmx - для описания конфигурации ВМ и .vdmk - файл жесткого диска ВМ. Помимо этих двух основных файлов, в шаблоне OVA есть и другие вспомогательные файлы. Помимо .OVA, есть еще другой формат .OVF, он менее удобен, так как там идет целый каталог с файлами .ovf, .vdmk, .vmx и т.д.

Скачайте с интернета файл - VMware-vCenter-Server-Appliance-5.5.0.20400-2442330_OVF10.ova

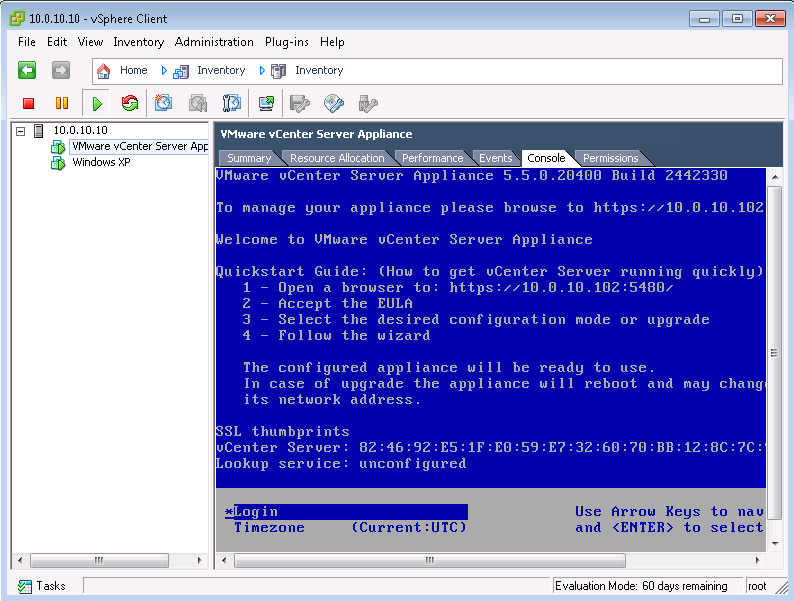

Теперь на гипервизоре запущены гостевые системы:

- VMware vCenter Server Appliance (VCSA)

- Windows XP

Посмотрим на них через вкладку Console и до установим их:

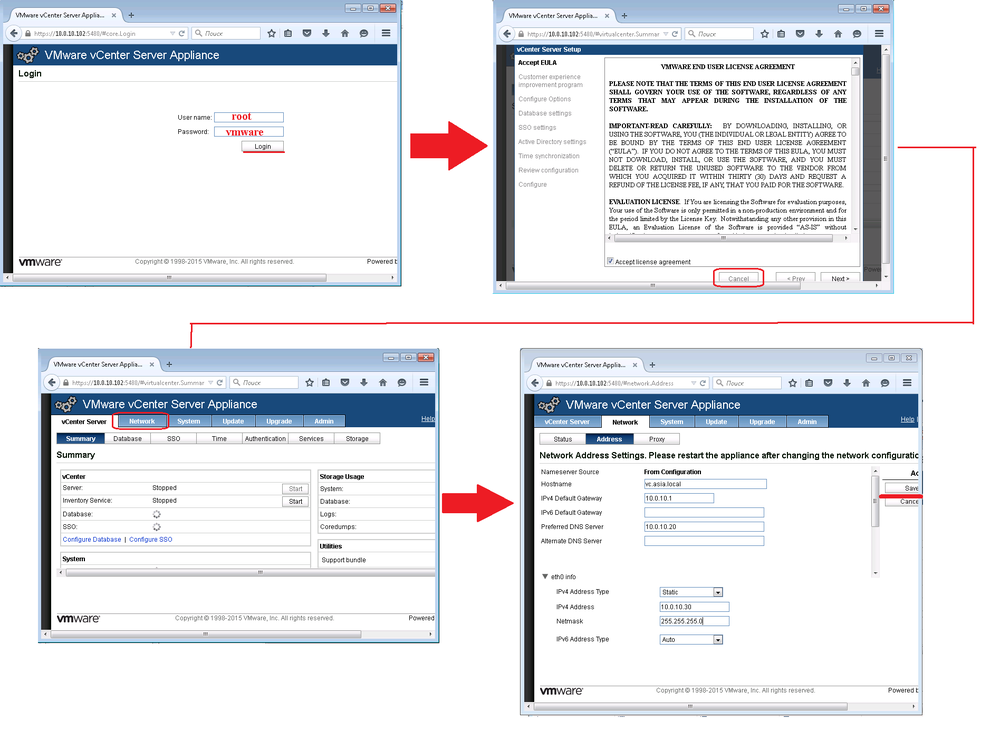

Скрин VCSA, здесь нам предлагают зайти на страничку https://10.0.10.102:5480/

чтобы продолжить установку системы управления виртуализацией.

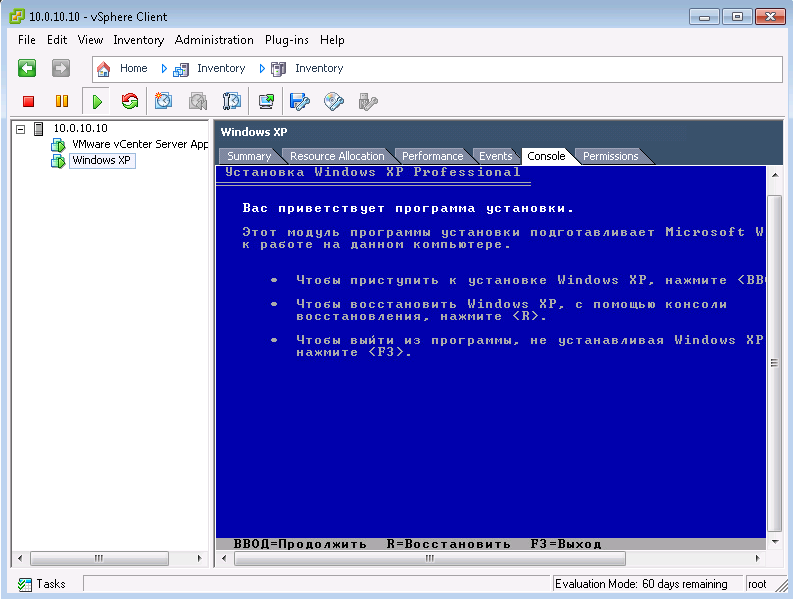

Обычная установка Windows XP.

Во вкладке Console видно как работает гостевая система.

Опять пачка скринов по установке VCSA, сперва нужно задать статический IP адрес 10.0.10.30 и прописать DNS и хостнейм.

По умолчанию хост с VCSA получил IP адрес по DHCP - 10.0.10.102

На последнем скрине заданы сетевые реквизиты.

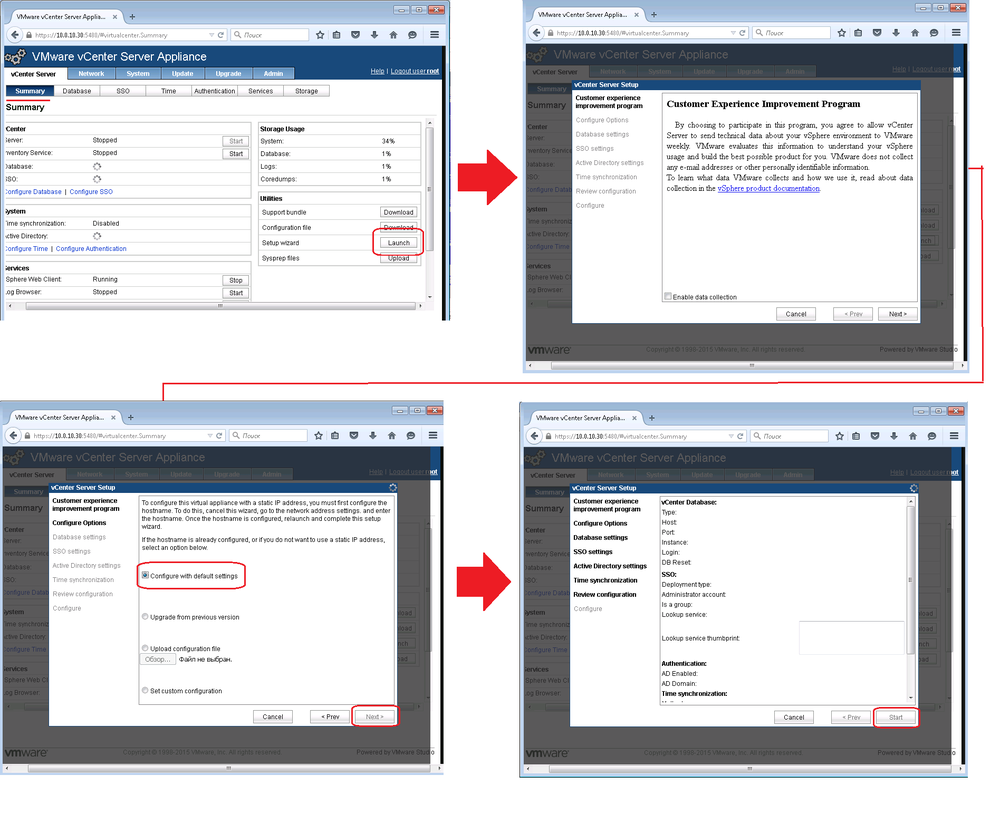

Далее уже идет установка VCSA:

После нажатия кнопки Start, идет установка и настройка VCSA, это очень длительный процесс, может запросто занят целый час времени.

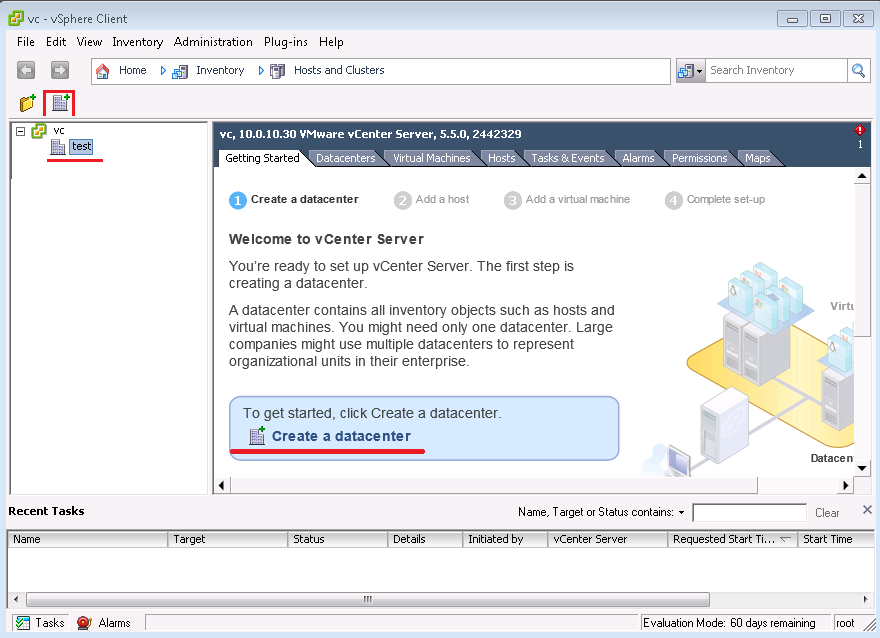

Все, VCSA установлен. Теперь надо зайти на него через vSphere Client, и создать Datacenter. Он нужен чтобы объединить хосты гипервизоров ESXi и настроить кластер. Напомню у VCSA адрес 10.0.10.30.

6. Тестируем фичи виртуализации

Немного про кластеры VMware:

HA (High Availability) - это делается с одним хранилищем данных и двумя гипервизорами. Виртуальная машина, например Windows XP, работает на хосте esxi1, при падении хоста esxi1, виртуальная машина Windows XP автоматически перезапустится на хосте esxi2. На перезапуск Windows XP уйдет примерно до 30 секунд.

Fault Tollerance - это когда виртуальная машина например Windows XP работает на первом гипервизоре esxi1, но при этом также работает ее точная теневая копия на хосту esxi2. При падении хоста esxi1, виртуальная машина Windows XP не заметно активируется на хосту esxi2. На активацию может уйти 1 секунда.

DRS - это кластер для балансировки ресурсов. То есть эта такая технология , которая пытается раскидать виртуальные машины между хостами (гипервизорами) чтобы производительность была максимальной, тем самым уменьшая конфликты за ресурсы. Но бывает так, что крайне не желательно, чтобы виртуальные машины кочевали на хост имеющий больший ресурс. Так как некоторые ВМ могут на одном хосту использовать общею память или возможно, виртуальные машины могут обмениваются трафиком 10Гб через виртуальные сетевые карты 10Гб, что позволяет повысить скорость и разгрузить физическую сеть. Да и линк между физическими хостами может быть не 10Гб, а всего 1Гб.

Поэтому используют правила которые прописываются в DRS. Также с помощью этих правил можно сделать действие наоборот, например чтобы два контроллера домена первичный и вторичный, не были на одном хосту, чтобы избежать прерывания связи с клиентскими машинами или службами которым нужен AD (например exchange или TMG). А если связь прервется, придется ждать какое-то время, чтобы доменные контроллеры заработали, что крайне не желательно в больших компаниях. Также можно раскидать DNS сервера, первичный и вторичный, по разным хостам, чтобы они оба не работали на одном хосте гипервизора.

Storage DRS кластер - это технология позволяет раскидывать машины между стораджами - хранилищями данных. Например при создании ВМ выбирается Сторадж где есть больше всего места, а также если вы создали машину с тонким диском и он сильно вырос, то Storadge DRS может в автоматическом или ручном режиме переместить машину на более емкий LUN.

6.1. High Availability

Само легко настраивается High Availibility (HA) кластер, и он кстати работает в компаниях в большинстве случаев. Поэтому начнем с него...

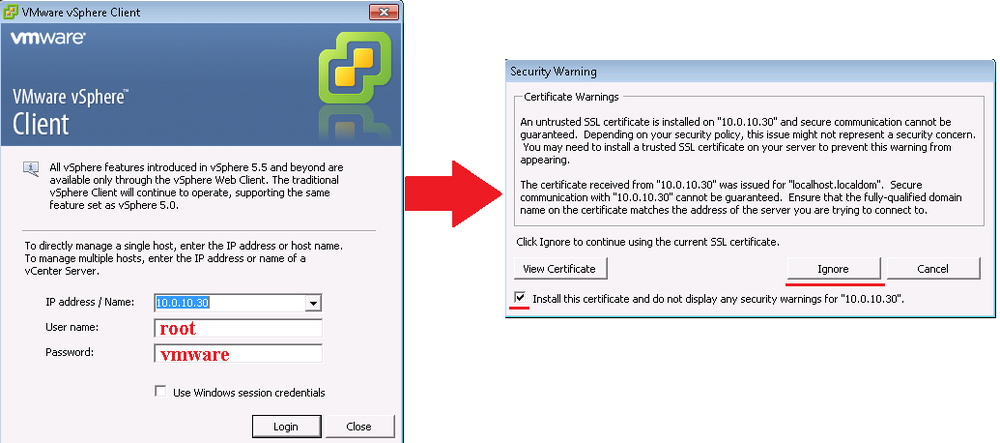

Подключаемся к vCSA (vCenter):

Обратите внимание, здесь уже другой IP адрес - нашего Virtual Center.

Логин и пароль по умолчанию - root / vmware

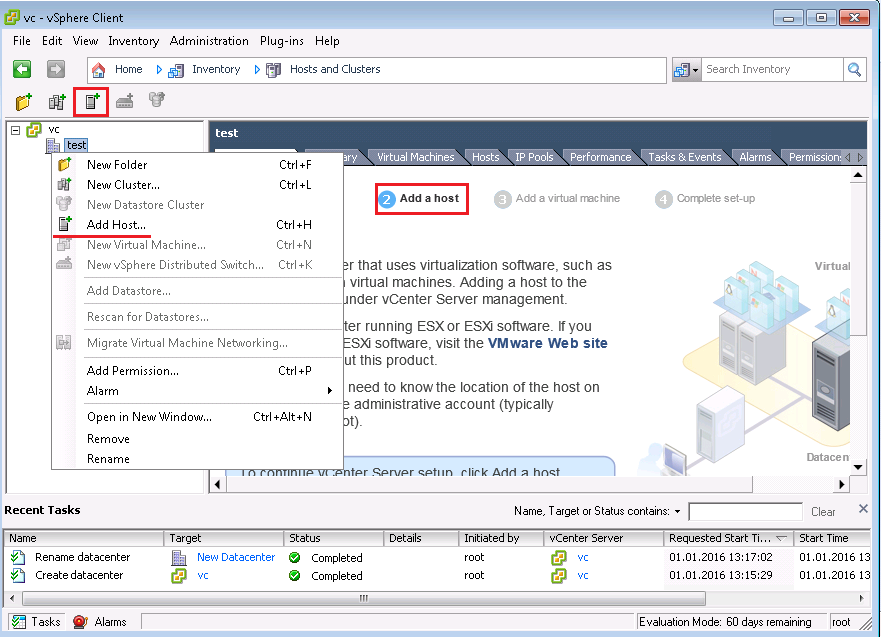

Теперь когда мы зашли в VCSA, потребуется создать Datacenter, это такая логическая единица, которая объединяет хосты гипервизоров ESXi.

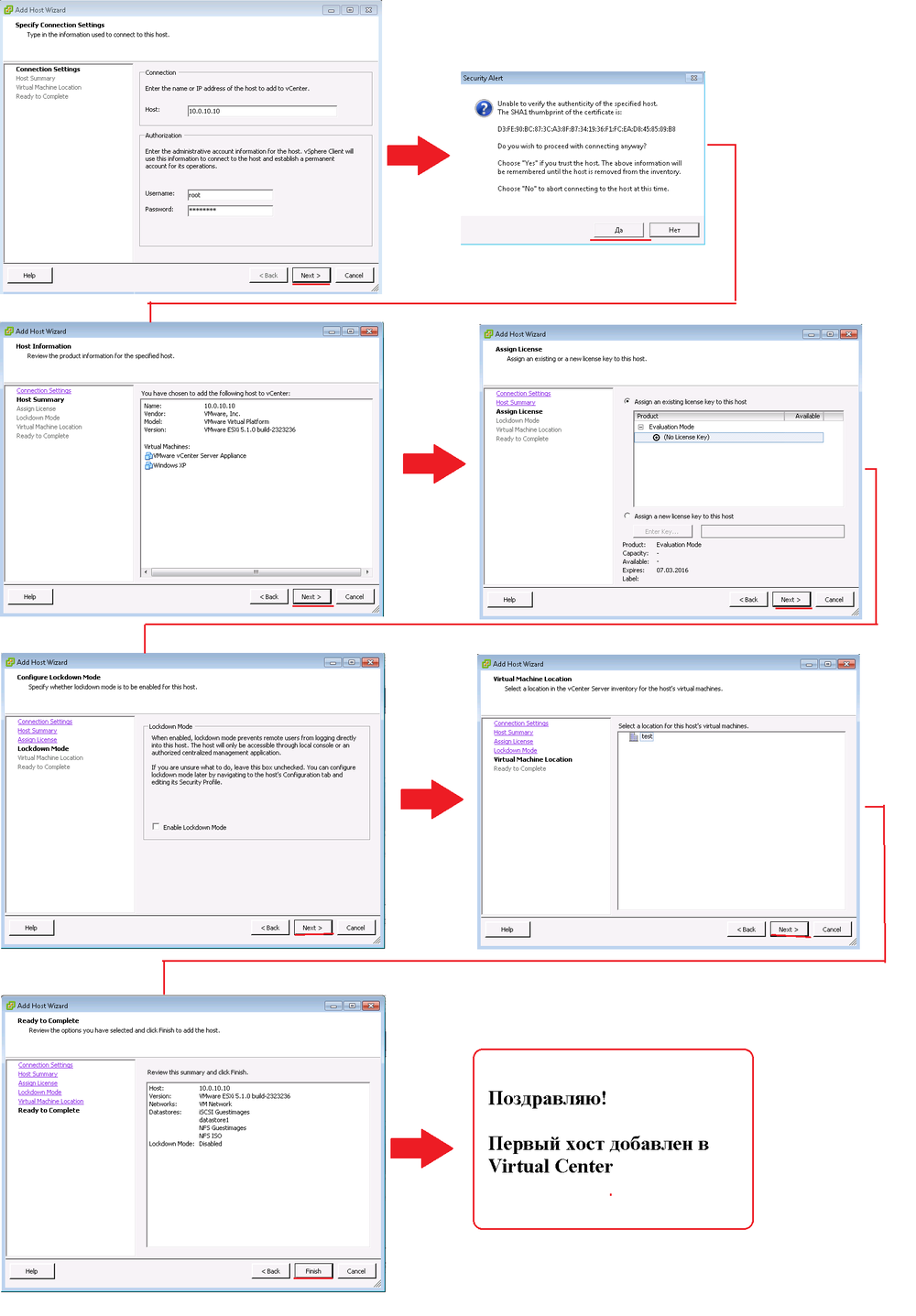

Нажимаем Add Host... и добавляем хост esxi1 (ip - 10.0.10.10)

На хосты ESXi устанавливаются агенты Virtual Center.

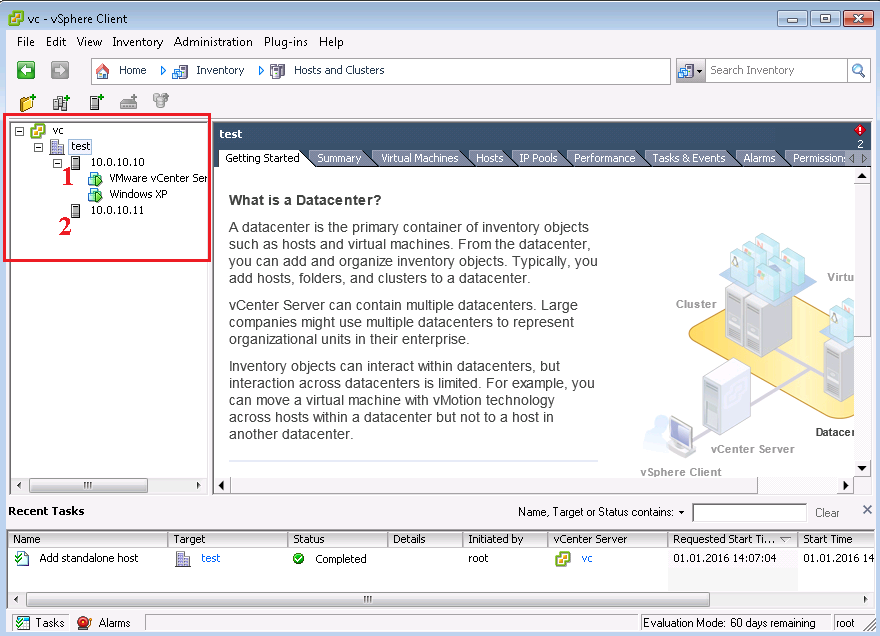

Через некоторое время хост появится внутри списка Datacenter. Таким же способом добавляем второй хост esxi2.

Итоговое окно - добавлены два сервера (хоста) с гипервизорами ESXi в центр управления Virtual Center (VCSA).

Теперь мы можем настроить отказоустойчивый кластер HA, хотя кластер может поддерживать одновременно функции HA и DRS.

Для наглядности пока сделаем кластер HA.

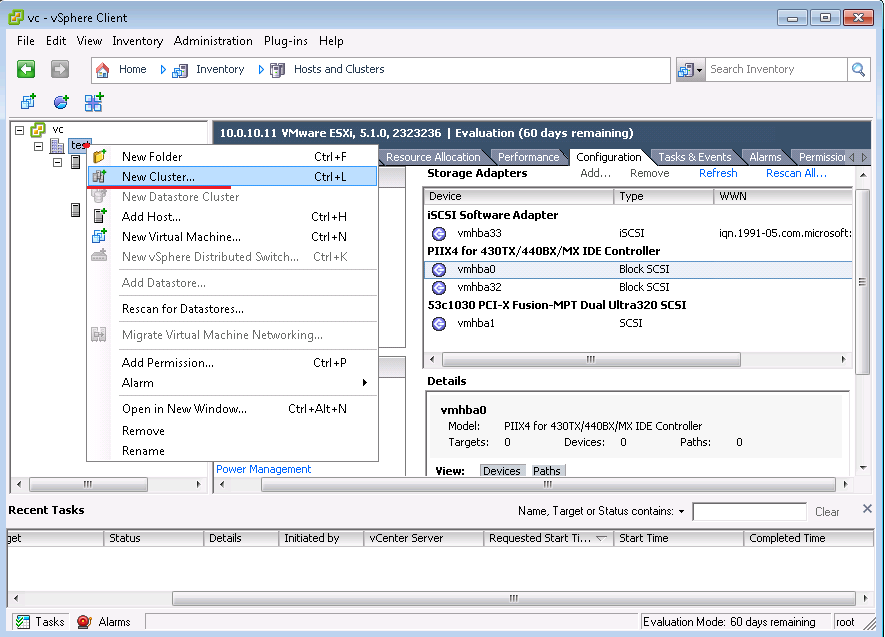

Щелкаем правой кнопкой на надписи test (Datacenter) и выбираем из меню New Cluster.

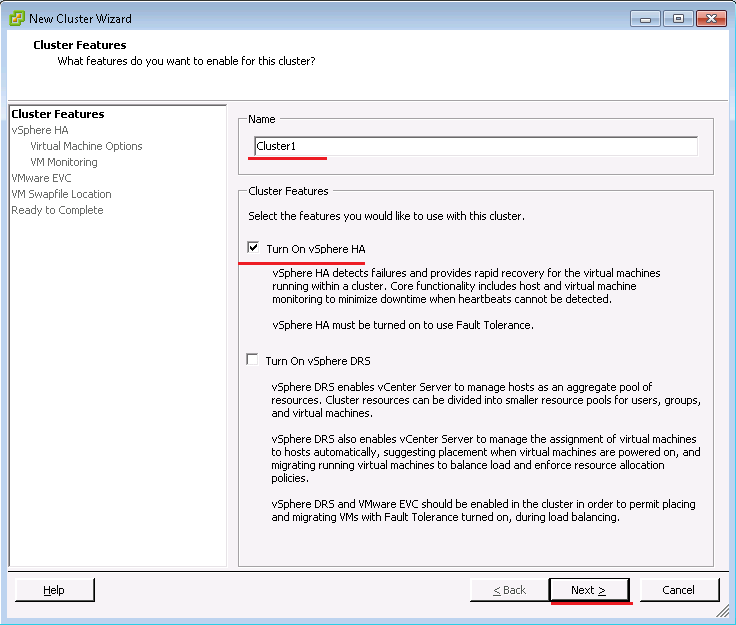

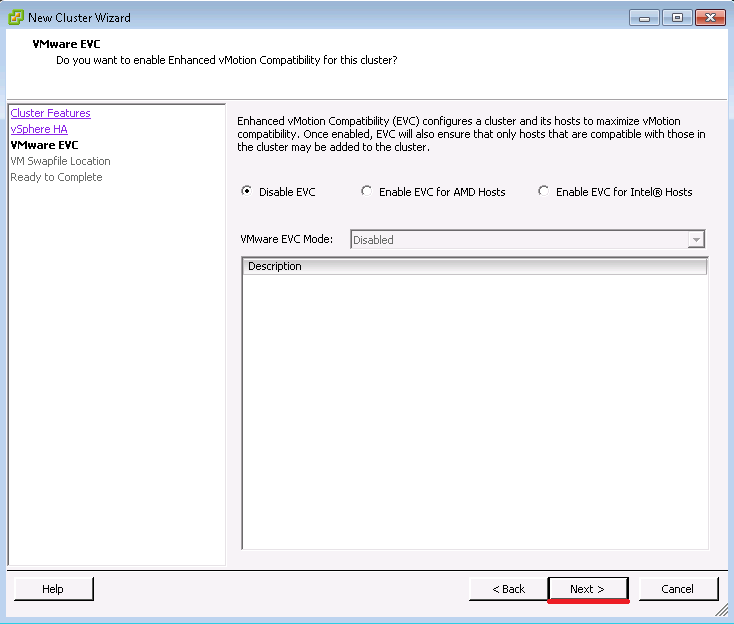

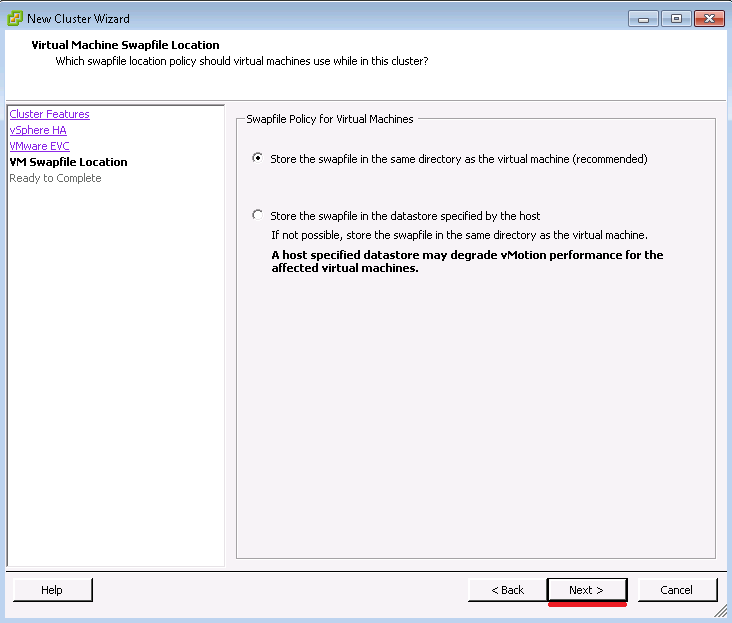

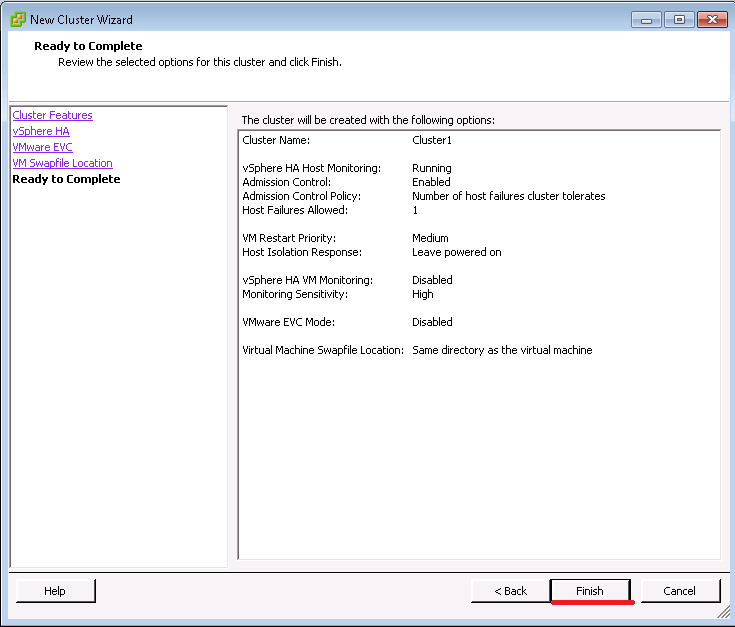

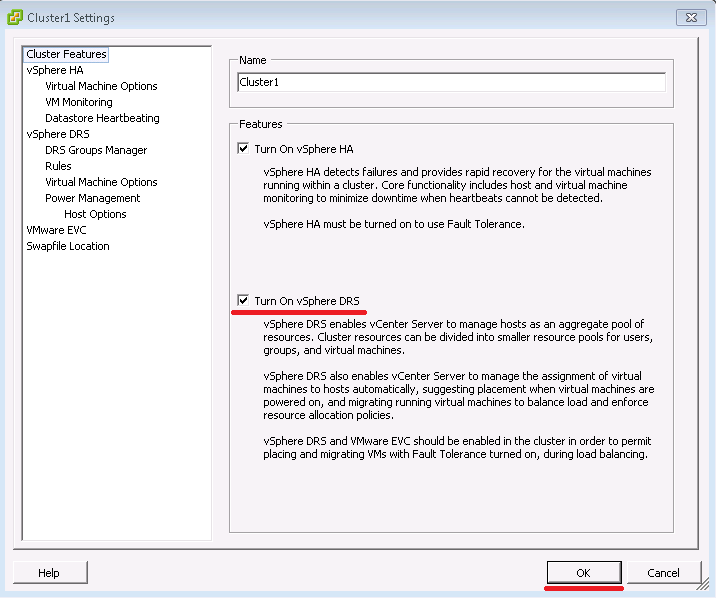

Даем имя кластеру Cluster1, ставим галку - Turn On vSpere HA (включить кластер высокой доступности) и нажимаем Next.

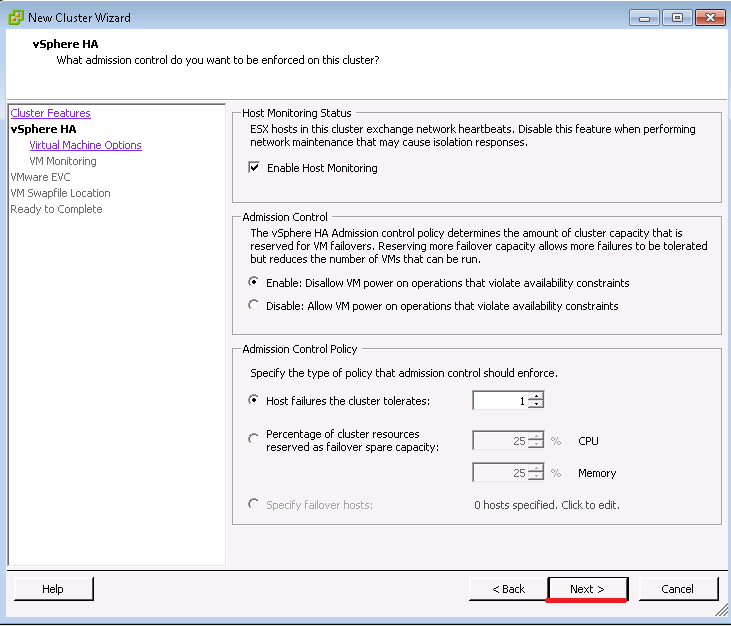

Нажимаем Next

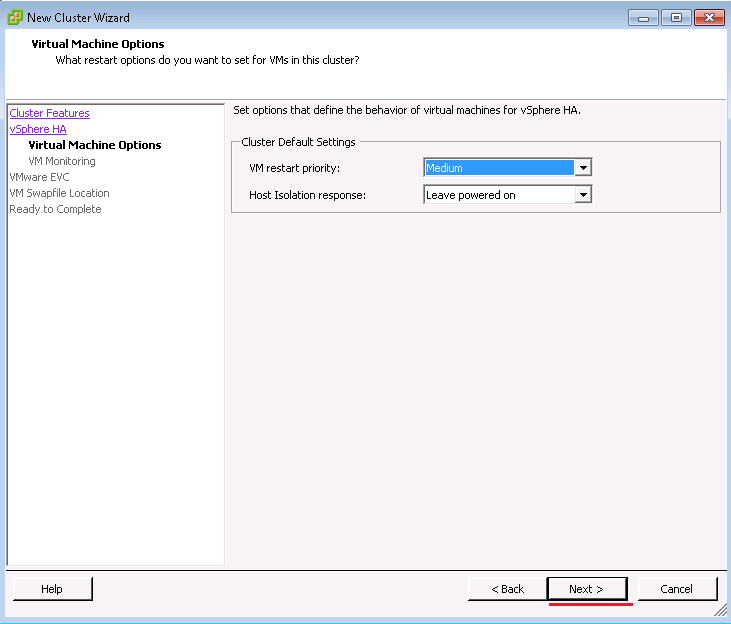

Нажимаем Next

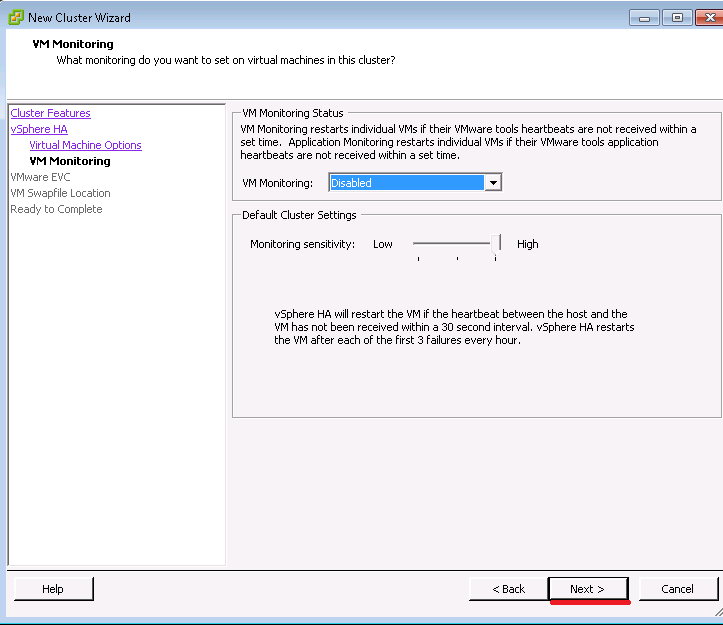

Нажимаем Next

Нажимаем Next

Нажимаем Next

Создан пустой кластер, осталось в него добавить хосты esxi1 и esxi2.

Перетаскиваем мышкой IP адреса 10.0.10.10 и 10.0.10.11 на надпись Cluster1. Тем самым мы добавили два хоста в наш созданный Cluster1.

Вот теперь все, у нас работает кластер высокой доступности - High Availability Cluster. Теперь если (хост) сервер esxi1 перестанет работать, его виртуальные машины запустятся на сервере esxi2, на что уйдет примерно 30 секунд. Или если ВМ работают на esxi2, они при отключении питания хоста esxi2, перезапустятся на хосту esxi1.

6.2. DRS

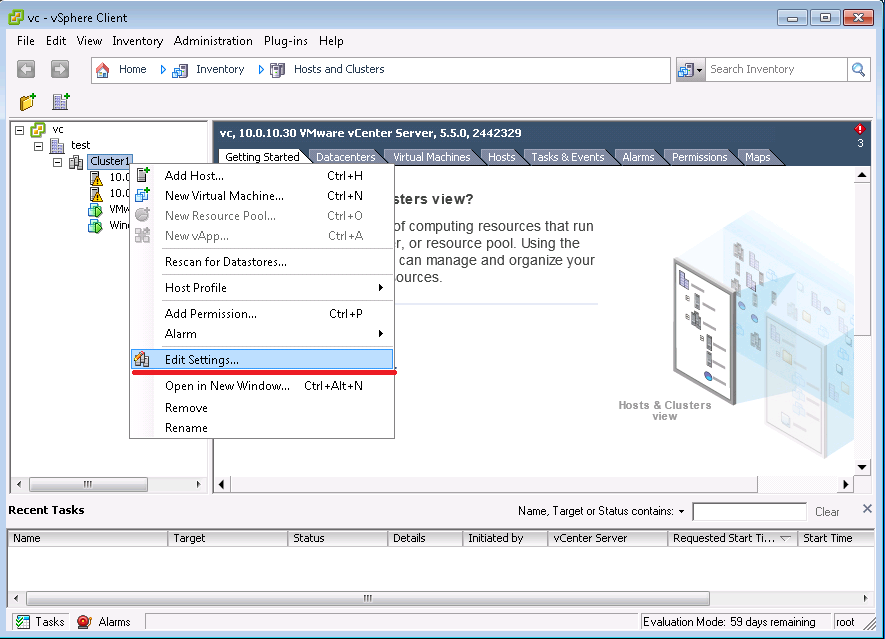

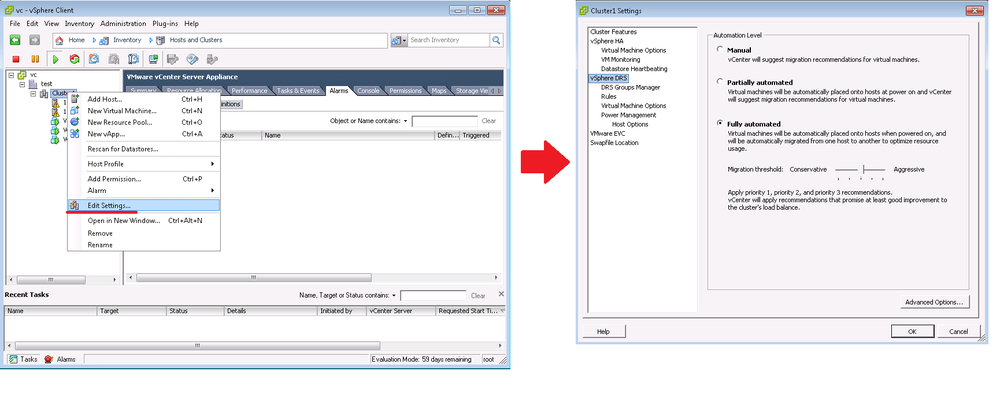

Для начала включим функцию DRS у нашего кластера с именем Cluster1:

Нажимаем правой кнопкой на надписи Cluster1.

Теперь (DRS) балансировшик ресурсов включен, но этого мало, нужно еще включить vMotion на двух хостах esxi1 и esxi2:

Проверим работу по следующему сценарию:

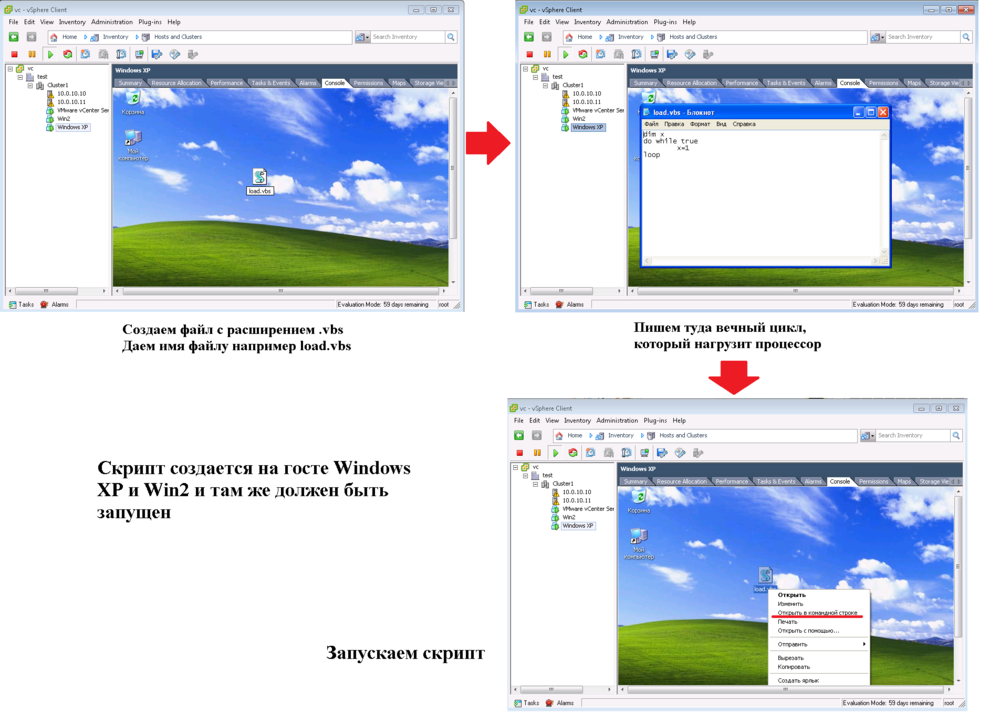

Искусственно загрузим процессор одного из гипервизор, например esxi1, для этого запустим на гостевой Windows XP специальный скрипт. После чего DRS решит что ресурсов у хоста с именем esxi1 стало мало, и перезапустит нагруженную Windows XP на другом хосте гипервизоре esxi2. Так как у него процессор и ОЗУ будут свободны по сравнению с хостом esxi1.

Далее клонируем гостевую систему Windows XP.

Здесь клонируем нашу гостевую Windows XP, которую создали ранее.

Также обязательно устанавливайте на гостевые виртуальные машины VMware Tools:

Это как в VirtualBox специальное дополнение (VBox Additions), через которые гипервизор взаимодействует с виртуальными машинами. Используя VMware Tools, гипервизор может использовать буфер обмена хост -> ВМ, перезагружать ВМ делая это мягко средствами гостевой ОС и т.д.

После установки VMware tools перезагрузите виртуальную машину.

На последнем скрине настройки DRS кластера. Балансировщик ресурсов (DRS кластер) может работать в режимах:

1. Ручном

2. Частично автоматическом

3. Полностью автоматическом

По умолчанию стоит именно полностью автоматический режим, при котором выбирается сервер со свободными ресурсами (CPU и ОЗУ).

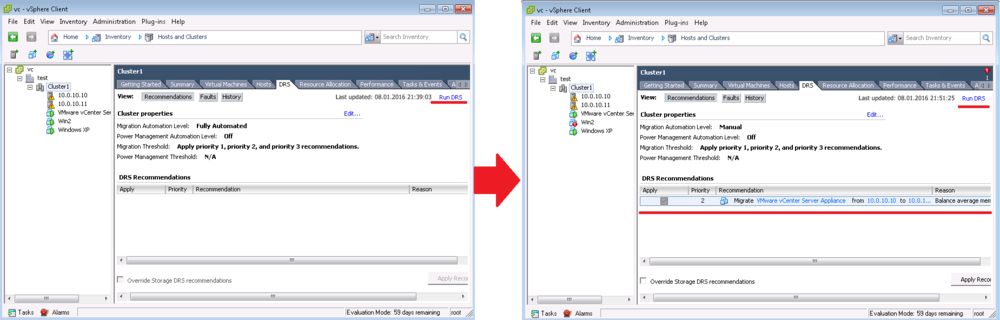

Если будет ручной режим, то во вкладке DRS кластера Cluster1, будут рекомендации, по перемещению ВМ на другой хост:

Здесь нам предложили переместить ВМ с VCSA на хост esxi2 (10.0.10.11).

При полностью автоматическом режим, эти рекомендации выполняются без вмешательства системного администратора.

При включении DRS, виртуальные машины можно перемещать мышкой с хоста на хост. Но лучше когда это происходит автоматически.

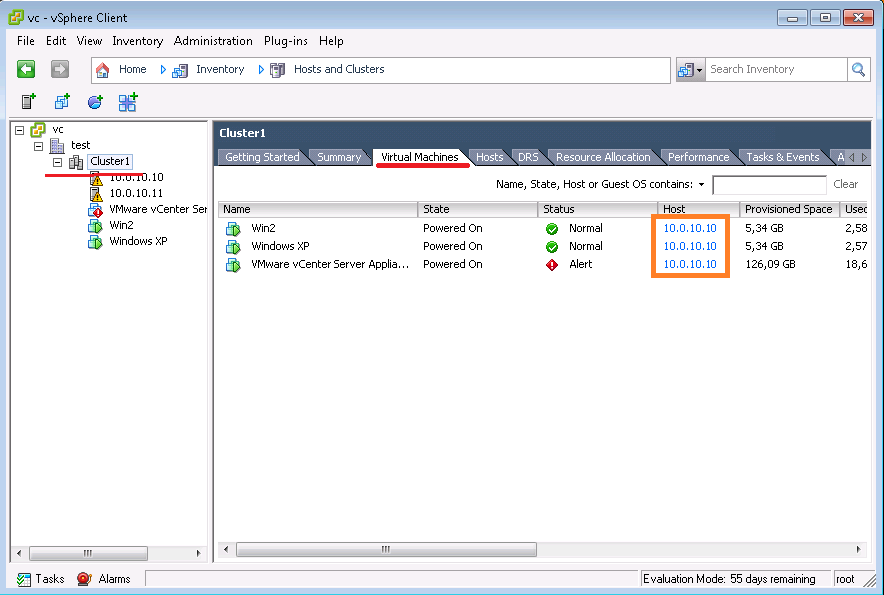

Сейчас все ВМ (VCSA, Windows XP, Win2) работают на хосте esxi1 с ip адресом 10.0.10.10.

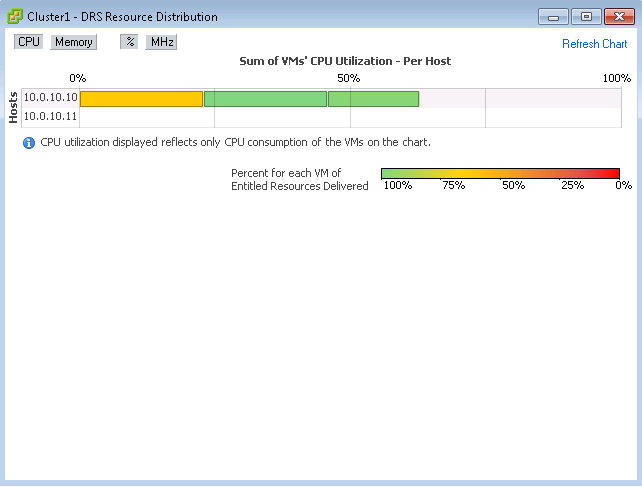

Так как все машины работают на хосте esxi1 с IP - 10.0.10.10, его ресурсы заняты, посмотрите картинку (Cluster1 -> Summary -> View Resources Distribution Chart). В то время когда хост esxi2 с IP - 10.0.10.11 - простаивает, его ресурсы свободны. Нагрузим гостевые системы Windows XP и Win2, чтобы они начали бороться за ресурсы. В итоге ВМ с VCSA должна переместится с хоста esxi1 (10.0.10.10) на хост esxi2 (10.0.10.11). Хотя возможно DRS решит перезапустить две Windows ВМ на хосте esxi2.

Сам скрипт:

dim=x

do while true

x=1

loop

Запускаем скрипт на Windows XP и Win2, после чего процессор хоста ESXi будет загружен.

После чего смотрим Distribution Chart:

Процессор загружен больше 50 процентов, значить теперь DRS распределит виртуальные машины по гипервизорам, перезапустив ВМ на гипервизоре esxi2 - который свободен.

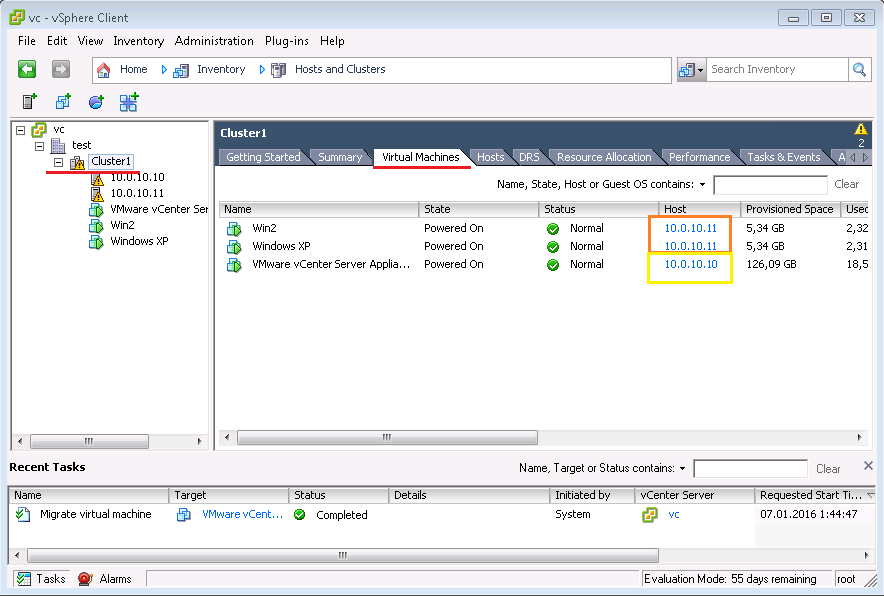

Через некоторое время, наши две ВМ с Windows (Windows XP и Win2) перезапустились на гипервизоре esxi2(10.0.10.11), а ВМ с VCSA осталась на хосте esxi1(10.0.10.10). Тем самым видно, что DRS распределил ВМ по хостам в целях более продуктивной работы - он работает!

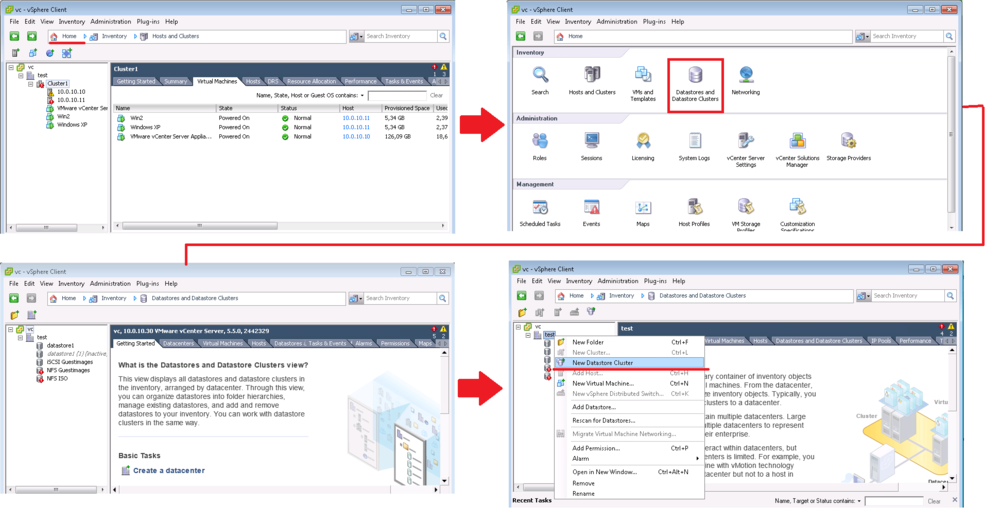

Storage DRS

Создаем Strorage DRS кластер:

Теперь надо выбрать iSCSI LUN-ы, чтобы ВМ кочевали между ними при заполненности или превышении кол-ва операций ввода/вывода.

Нажимаем Finish, создан DRS кластер всего с одним LUN. Для работы такого кластера, нужно как минимум два LUN, чтобы при заполненности 80 процентов например LUN1 на котором две гостевые машины, происходило кочевание ВМ с виртуальным жестким диском .vdmk на например LUN2, у которого места дай боже. То есть суть данной технологии такова - по идее в компаниях используется 2 и более хранилищ для ВМ, при создании ВМ будет выбран сторадж более свободный, поэтому администратору не надо думать, в каком сторадже больше всего свободного места. А также, если машины уже созданы с тонкими дисками, и эти диски за время работы ВМ хорошо так выросли, их жесткие диски будут равномерно распределены по страджам такого кластера.

Рисунок где показан DRS кластер всего с одним хранилищем (LUN-ом).

6.3. Fault Tolerance

Чтобы задействовать FT, потребуется соблюсти много требований.

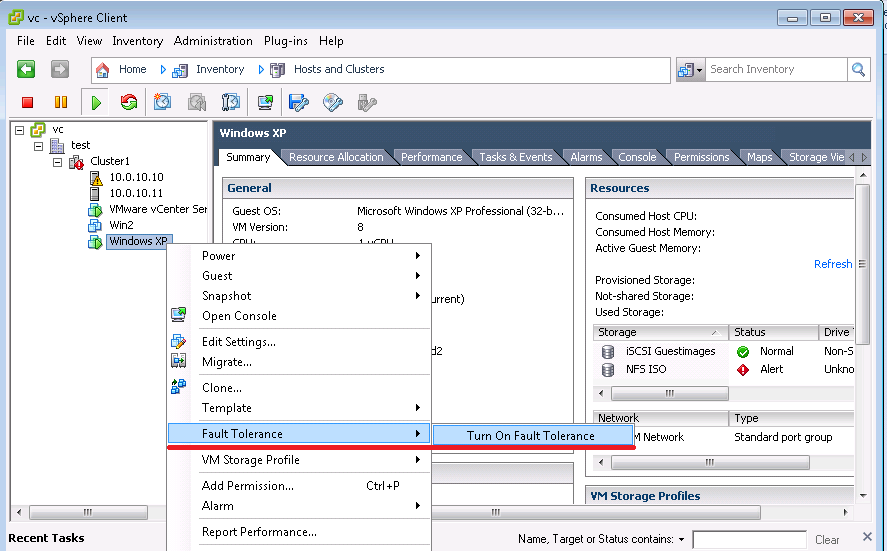

Включение FT:

1. Выберите ВМ, например Windows XP и включите FT:

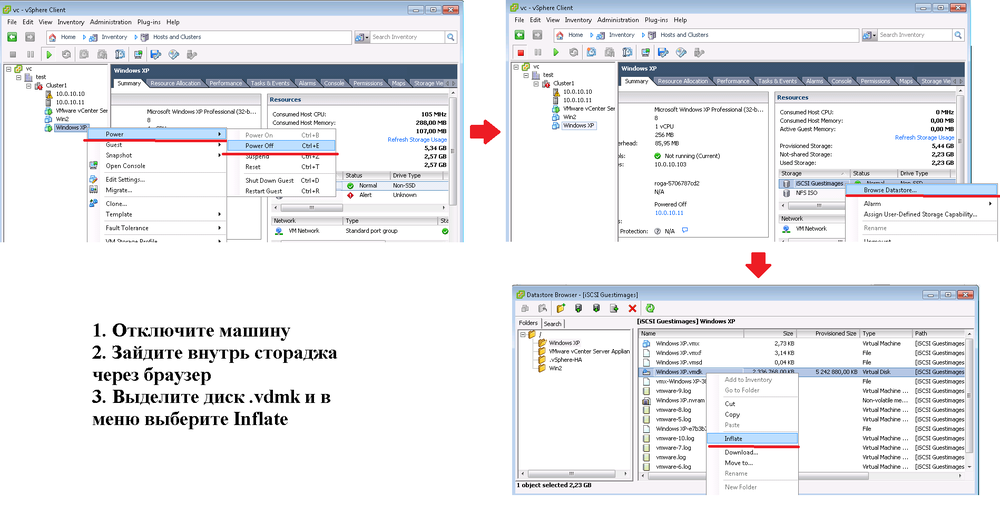

2. Диcк ВМ должен быть толстым (thick). Поэтому для теста надо создать новую ВМ или клонировать существующею c тонким диском (thin) указав что у клона диск будет толстым (thick) или сконвертировать в браузере стораджа текущий диск:

3. Специальный сетевой интерфейс

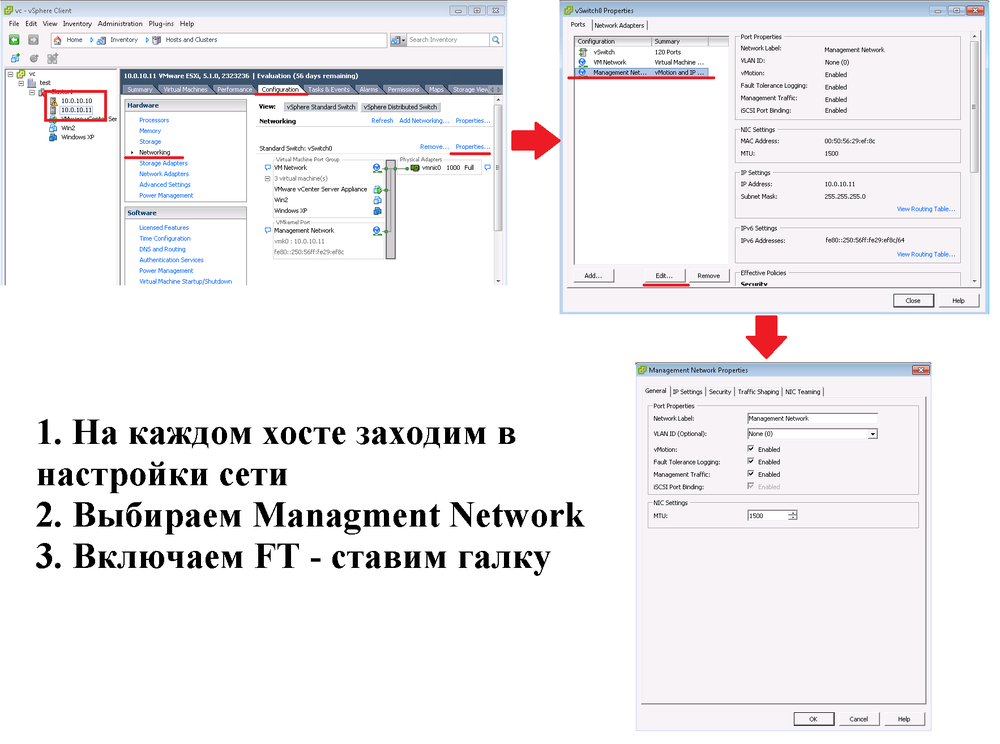

Для работы FT нужно создать отдельный порт VMKermel или использовать существующий, я использовал Managment Network:

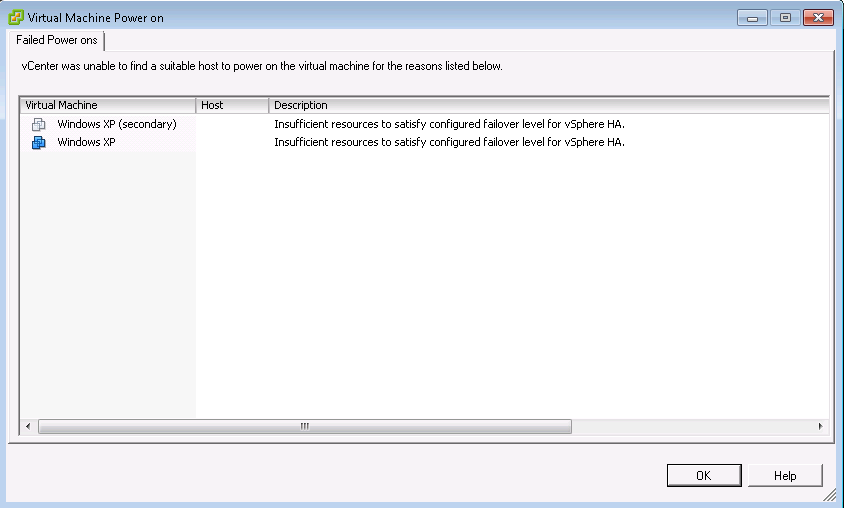

4. Если у вас всего два хоста с гирвизором, vCenter может ругаться:

Что якобы нужен еще один хост. У нас его нет, поэтому меняем настройки кластера:

Теперь FT включена.

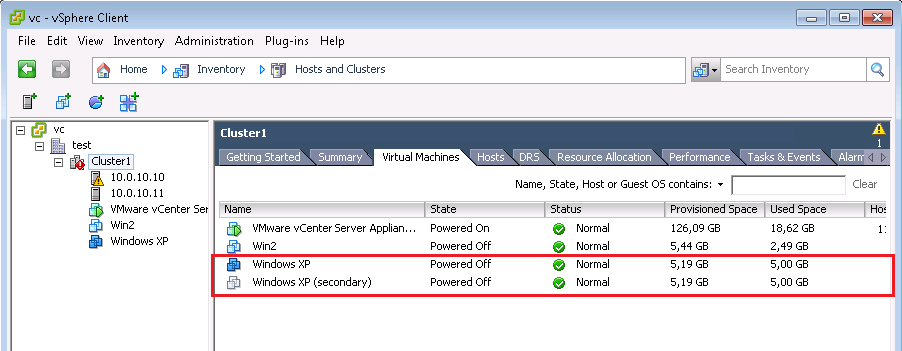

Создана вторая копия гостя Windows XP с именем Windows XP (secondary). Первая ВМ работает на гипервизоре esxi1, вторая на esxi2. Если первая ВМ умрет, автоматически за секунду начнет работать вторая ВМ.

7. Резервное копирование

Самый простой способ для бекапа, это использовать Veeam Backup. Ставится он легко, и очень просто настраивается. Указываете какие кластеры, хосты или машины резервировать, а также когда запускать бекап и сколько дней хранить копии до их удаления. Не забывайте настраивать отправку отчетов по почте. Бесплатная версия умеет делать только полный бекап. Поэтому можете настроить полное резервное копирование всех виртуалок один раз на выходных. А бекап критично важных ВМ производить каждый день ночью.

8. Конвертация машин

Если вам нужно из физической машины сделать виртуальную или поместить текущею ВМ вашего гипервизора в ESXI, воспользуйтесь VMware Converter.

ССЫЛКИ:

1. Начинаем работать с VMware vSphere за 1 вебинар

3. Установка и начало работы с VMware vSphere за 60 минут

4. Кластеры VMware - демонстрация vMotion,HA,FT

5. VMWare ESXi 5.1 (Free) Easily backup your Virtual Machines using Veeam Backup & Replication (Free)

6. Лаборатория Veeam: Установка и настройка Veeam Backup & Replication